HPCTECH Solution

- トップページ

- 製品案内:ハードウェア

- InfiniBand HCA Card & Switch

Mellanox InfiniBand

Mellanox InfiniBand は ハイパフォーマンスコンピューティング、人工知能、およびビッグデータ処理等、昨今欠かすことのできないソリューションです。 GPUDirect RDMA、NVMe over Fabrics 、MPI タグマッチングや集合プロトコルのネイティブハードウェアオフロード といったシステムパフォーマンスの最大化を目的とした最先端のネットワーク機能を幅広く提供しています。

最高のデータ速度と最小の遅延、スマートな高速化、最高の効率を備えた InfiniBandは 増大するデータ、複雑なシミュレーション、パフォーマンスのボトルネックの解消など、研究を加速させるには最適な選択肢と言えるでしょう。

各レーンごとの実効スループット

| SDR | DDR | QDR | FDR | EDR | HDR | NDR | XDR | |

|---|---|---|---|---|---|---|---|---|

| 1X | 2 Gbit/s |

4 Gbit/s |

8 Gbit/s |

13.64 Gbit/s |

25 Gbit/s |

50 Gbit/s |

100 Gbit/s |

250 Gbit/s |

| 4X | 8 Gbit/s |

16 Gbit/s |

32 Gbit/s |

54.55 Gbit/s |

100 Gbit/s |

200 Gbit/s |

400 Gbit/s |

1000 Gbit/s |

| 12X | 24 Gbit/s |

48 Gbit/s |

96 Gbit/s |

163.64 Gbit/s | 300 Gbit/s |

600 Gbit/s |

1200 Gbit/s |

3000 Gbit/s |

Mellanox InfiniBand & Ethernet Adapter Card

ConnectX-6 VPIは業界最高のスループットとメッセージレートを提供します。200Gb/sの HDR InfiniBand、100Gb/sの HDR100 InfiniBand、および 200Gb/sのイーサネット速度を提供する初のアダプタである ConnectX-6 VPIは、HPCデータセンターをエクサスケールレベルのパフォーマンスと拡張性へと導く完璧な製品です。

| General Specs | ConnectX-5 VPI | ConnectX-6 VPI |

| Ports | Single, Dual | Single, Dual |

| Port Speed (Gbs) |

IB: FDR, EDR Eth: 10, 25, 40, 50, 100 |

IB: FDR, EDR, HDR 200, HDR 100 Eth: 10, 25, 40, 50, 100, 200 |

| PCIe | Gen3 x 16, Gen4 x 16 | Gen3 x 16, Gen4 x 16, 32 lanes as 2 x 16-lane PCIe |

| Connectors | QSFP28 | QSFP56 |

| Message Rate (million msgs/sec) |

200 (ConnectX-5 Ex, Gen4 server) 165 (ConnectX-5, Gen3 server) |

215 |

| Latency (us) | 0.6 | 0.6 |

●メリット

▶業界トップのスループット、低遅延、低CPU使用率、高メッセージレート

▶ホストチェイニングテクノロジーに基づいた画期的なラックデザインのストレージと機械学習

▶x86、Power、ARM、GPUベースのコンピュートとストレージプラットフォーム用スマート

インターコネクト

▶NVMeオーバーファブリックオフロードを含む高度なストレージ能力

▶柔軟なパイプラインプログラマビリティ対応のインテリジェントネットワークアダプタ

▶Network Function Virtualization (NFV)を含む仮想化ネットワークで最先端のパフォーマンス

▶効率的なサービスチェイニング能力を実現

●主な機能

▶ポートあたり HDR 200Gb/sの InfiniBandまたは 200Gb/sのイーサネットおよびそれ以下の

すべての速度

▶最大 215Mメッセージ/秒

▶タグマッチングとランデブーオフロード

▶信頼性の高いトランスポート上でのアダプティブルーティング

▶バックグラウンドチェックポインティング用のバーストバッファオフロード

▶NVMeオーバーファブリック(NVMf)ターゲットオフロード

▶ホストチェイニングによりバックエンドスイッチ排除

▶vSwitch / vRouterオフロード強化

▶柔軟なパイプライン

▶オーバーレイネットワーク用 RoCE

▶PCIe Gen3および Gen4対応

▶消失訂正符号のオフロード

▶IBM CAPI v2対応

▶T10 DIFシグネチャハンドオーバー

▶メラノックス PeerDirectコミュニケーション加速化

▶NVGREおよび VXLANカプセル化トラフィックにおけるハードウェアオフロード

▶エンドツーエンド QoSおよび輻輳制御

▶ハードウェアベースの I/O仮想化

Mellanox Edge Switch

速くなったサーバーと、ますます複雑になる計算処理を使用するハイパフォーマンスストレージおよびアプリケーションが組み合わさることで、データ帯域幅の要件も飛躍的に上昇しています。次世代プロセッサを使用したサーバーが展開されるに従い、ハイパフォーマンスコンピューティング(HPC)環境およびエンタープライズデータセンター(EDC)では、メラノックスの次世代 HDR InfiniBand高速スマートスイッチが実現する帯域幅のすべてが必要とされます。

|

|

|

|

| Model No. | QM8700 | SB7700 | SN2100 |

| MAX Link Speed | HDR | EDR | 100GbE |

| Ports | 40 | 36 | 16 |

| Throughput | 16Tb/s | 7.2Tb/s | 3.2Tb/s |

| Connectors | QSFP56 | QSFP28 | QSFP28 |

| Switch Latency | 90ns | 90ns | 300ns |

| Height | 1U | 1U | 1U |

| 電源冗長化 | 標準装備 | 標準装備 | 標準装備 |

QM8700 Series - Mellanox Quantum HDR Edge Switch

●メリット

▶パフォーマンス、電力、密度で業界トップのスイッチプラットフォーム

▶総合的な通信高速化

▶迅速かつ簡単なセットアップおよび管理

▶ファブリック輻輳をなくしパフォーマンス最大化

▶以前の速度への下位互換性

●主な機能

▶パフォーマンス

• 1Uスイッチには 40 X HDR 200Gb/sポート

• 1Uスイッチには 80 X HDR100 100Gb/sポート

• スイッチのスループット総計 16Tb/s

• 最大 15.8Bメッセージ毎秒

• 130nsのスイッチ遅延

▶最適化デザイン

• 1+1冗長&ホットスワップ対応電源

• 80ゴールド+とエネルギースター認定の電源

• デュアルコア x86 CPU

▶アドバンスドデザイン

• SHIELD - ファブリックの自己修復力を実現

• SHARP - まとまった演算をCPUからスイッチネットワークへとオフロード

• アダプティブルーティング

• InfiniBandルーター

• 総合的なオフロード(メラノックス SHArP技術)

• VLマッピング(VL2VL)

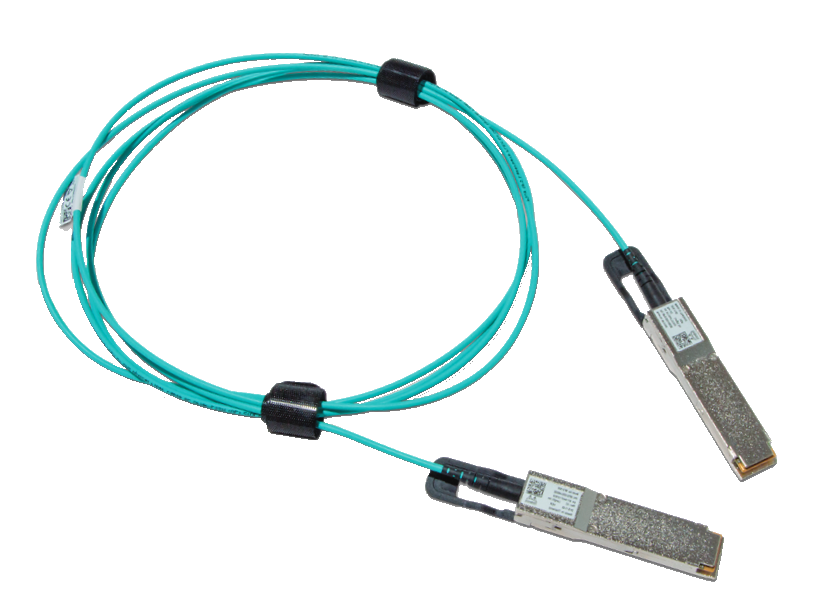

HDR / HDR100 LinkX ケーブル一覧

| モデル名 | 概要 | 長さ | |

|

MCP1650-H シリーズ |

HDR 200Gb/s QSFP56 ダイレクト・アタッチ・カッパーケーブル |

0.5 / 1 / 1.5 / 2 m |

|

MCP7H50-H シリーズ |

HDR-to-HDR100 x2 DAC スピリッター |

1/ 1.5 / 2 m |

|

MFS1S00-HxxxE シリーズ |

200Gb/s HDR QSFP56 MMF Active Optical Cable |

3 / 5 / 10 / 15 / 20 / 30 / 50 / 100 m |

|

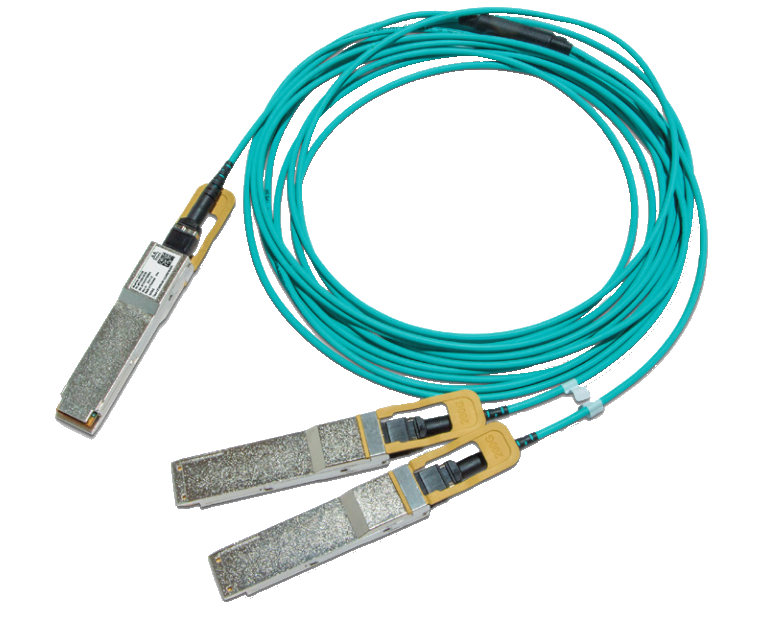

MFS1S50-HxxxE シリーズ |

200Gb/s HDR to 2x100Gb/s HDR100 (QSFP56 to 2xQSFP56) MMFアクティブ・オプティカル・ スピリッターケーブル |

3 / 5 / 10 / 15 / 20 / 30 m |

|

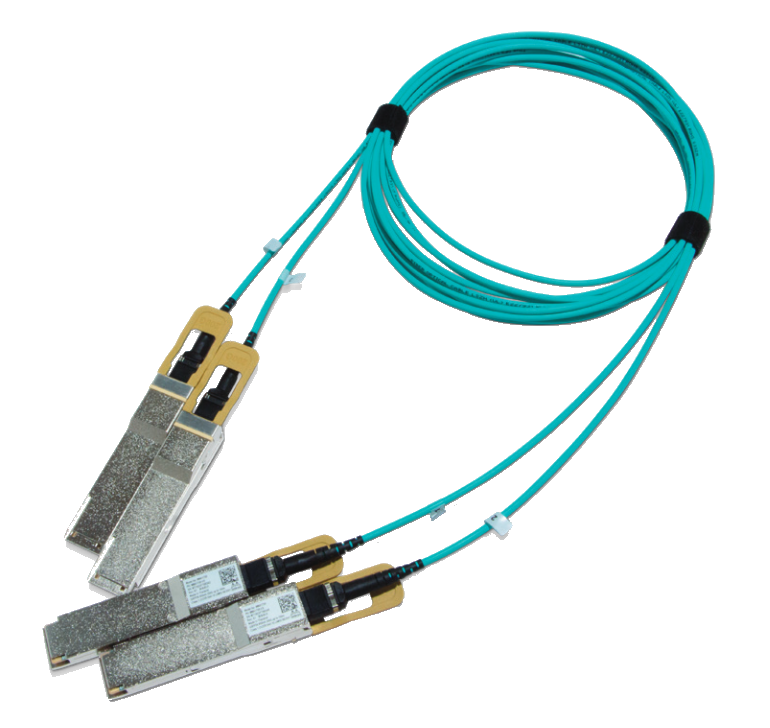

MFS1S90-H シリーズ |

2x200Gb/s to 2x200Gb/s (2xQSFP56 to 2xQSFP56) MMF アクティブ・オプティカル・ クロスコネクト・スピリッター・ H-ケーブル |

3 / 5 / 10 / 15 / 20 / 30 m |