GPU Solution:DEEP LEARNING

- トップページ

- 製品案内

- GPUラインナップ

- DEEP LEARNING

- HPCT Mini-POD Series

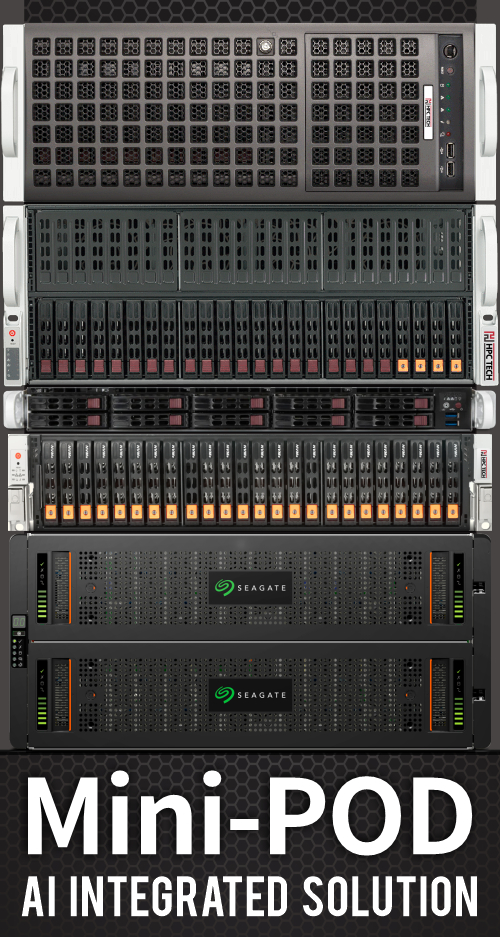

MiniPOD - AI INTEGRATED SOLUTION

AI や HPC といった大規模なワークロードは日々発生し、処理され、新しい発見があり、また新たなワークロードが生まれています。この増え続ける多様なワークロードの解決に、ワークステーションやアクセラレータを組み込んだサーバ、あるいはスーパーコンピュータ等が活躍しています。

今日ではアクセラレータを使う事で性能を補う事が一般になり、有名なところでは、NVIDIA 社の GPU を搭載した DGX シリーズや、その DGX シリーズを組み込んだクラウドネイティブなスーパーコンピュータである DGX SuperPOD、そしてその技術を応用した計算機が数多くあります。とはいえ、いくら世の中に大規模なシステムがあっても結局は色々な理由で利用が出来なかったり、逆に大規模すぎて手に余ったりもします。

例えば

▶「もう遅いマシンは使いたくない。」でも外部アクセスが禁止されていたり

データの外部持ち出しが禁止されている。

▶「一気にすべての環境をそろえて大規模に!」とは考えても予算が…。

▶どうせ買うなら、今後の設備投資を考慮に入れて将来的にも使えてスケール

しやすい形にしたい。想像つかんけど…。

▶増設しても使い勝手は変わらずに同じ感覚で高性能なシステムを使いたい。

というか毎度覚えなおすのが面倒くさい。

このような悩みは尽きないものです。

そこで HPC テックは GPU サーバを中心としつつ、管理サーバやストレージサーバをひとつにまとめた、言わば

「Mini-POD」をシステム化してみました。

ラックに、ログインノード、ストレージノード、GPU ノード、ネットワーク、をまとめ、システム管理に Bright Cluster Manager を利用することでスケールアウトにも柔軟に対応できます。

Mini-POD はなるべく柔軟なシステムを目指し、基本セットは変わらずに今のワークロードや予算と相談して、スタートをどこのランクからでも始められるようになっています。また昨今では入手が困難な Infiniband スイッチの他に 100GEthernet スイッチも選べます。ラックについても通常のオープンラックの他に静音ラックモデルも用意しました。

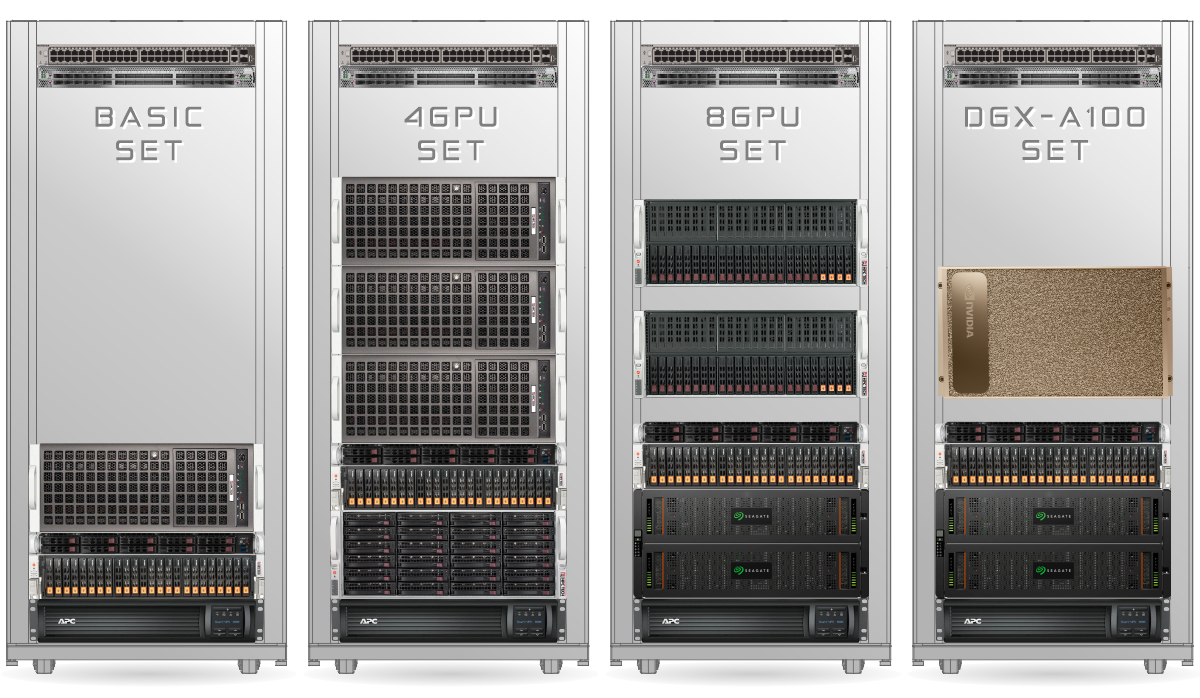

Mini-POD ランク別仕様例

| ベーシックセット | 4GPU x3 セット | 8GPU x2 セット | DGX-A100 セット | |

| 型式 | HPCT Mini-POD Series | |||

| Manage Node |

HPCT RS1X31 | |||

| Manage System |

Bright Cluster Manager | |||

| Network | 10G Ethernet & 100G Ethernet or InfiniBand | |||

| Interconnect | 100G Ethernet or InfiniBand | |||

| I/O Throughput |

5GB/s | 10GB/s | ||

| GPU Server |

HPCT WRSX32-4GP x1 |

HPCT WRSX32-4GP x3 |

HPCT RS4E32-8GP x2 |

NVIDIA DGX A100 x1 |

| Max GPUs | PCIe 4 GPU | PCIe 12 GPU | PCIe 16 GPU | SXM 8 GPU |

| FLASH Storage |

HPCT SG2E32-GRAID | |||

| HDD Stoarage |

- | HPCT SS4X32-24B | Seagate Exos X 5U84 | |

| HDD Storage Bay |

- | 24 | 42 | 84 |

| Racks | HPCT YSR シリーズ | |||

| Rack Size |

700 (W) x 1200 (D) x 1550 (H) |

|||

| UPS | APC RM3000 2U | |||

| PDU | L6-30 x1 | L6-30 x2 | ||

| L6-20変更 | 〇 | 〇 | - |

- |

| 電源系統 | 100V 30A x1 200V 30A x1 |

100V 30A x 1, 200V 30A x2 |

||

| 必要電力 |

3440W |

7340W | 8660W | 9340W |

| 合計荷重 | 300Kg | 450Kg | 500Kg | 500Kg |

Mini-POD 構成説明

Manage Node

管理ノードとして HPCT RS1X31 をご提案例その1にしました。

SATA SSD をハードウェア RAID で束ね、高速な読み書きが必要な場合は NVMe に変更できます。

HPCT RS1X31

https://archive-lib.hpctech.co.jp/hardware/hpct-rs1x31_edit.html

例:7.68TB SSD x10, スペア 2, RAID6

実効容量 46.08TB

Manage System

クラスタ管理ツールに Bright Cluster Manager を提案します。

NVIDIA 社ではメインに使われるなど運用や管理を用意にするマネジメントツールです。

ジョブスケジューリングには、すでに多くのシステムで広く使われている Slurm を採用しています。

Bright Cluster Manager

https://archive-lib.hpctech.co.jp/hardware/bright-for-hpc.html

Network - Interconnect

速度と高性能を求めるなら InfiniBand 一択です。

Mini-POD は GPU 性能を最大化するため、内部ネットワークに高スループット、低レイテンシの Infiniband を利用することができます。

Infiniband は RDMA 通信の他に NVMe over Fabric が使え、ストレージが不足しがちな GPU ノードが外部にある高速な NVMe ボリュームにリモートアクセスする事を可能とします。

NVIDIA Networking Solutions

https://www.nvidia.com/ja-jp/networking/

GPU Server

ハイエンド GPU を 4基~ 8基搭載できるサーバを選択できます。

・GPU 最大 4基搭載 - HPCT WRSX32-4GP

・GPU 最大 8基搭載 - HPCT RS4E32-8GP

・NVIDIA DGX A100

HPCT WRSX32-4GP

https://archive-lib.hpctech.co.jp/gpuproduct/hpct-wrsx32-4gp.html

HPCT RS4E32-8GP

https://archive-lib.hpctech.co.jp/gpuproduct/hpct-rs4e32-8gp.html

NVIDIA DGX A100

https://archive-lib.hpctech.co.jp/gpuproduct/nvidia-dgx-a100.html

FLASH Storage

NVMe SSD 対応ハードウエア RAIDの限界を超え、リードライト性能をより高く求めた製品です。

ネットワークストレージ性能

| NVMeOF | IOPS | BW | |

| Sequential READ | 11.5k | 12.1GB | |

| Sequential Write | 9.9k | 10.4GB | |

| 4K Random Read | 2059k | 8042MiB | |

| 4K Random Write | 602k | 2351MiB | |

HPCT SG2E32-GRAID

https://archive-lib.hpctech.co.jp/hardware/hpct-sg2e32-graid.html

HDD Stoarage

HDD メーカーが考えたサーバ Seagate Exos X シリーズを選定しました。

最大84台のディスクを搭載でき、最大容量は 20TB HDD を使用で 1.68TB となります。

再構築の高速化や緊急対応が減る機能があり、電力的にも他社よりも省電力です。

Seagate Exos X 5U84

https://archive-lib.hpctech.co.jp/hardware/seagate-exos-x-5u84.html

Server Rack

大学や研究所でサーバルームが無くとも設置し通常運用ができるよう静音ラックを選定しました。

増えるサーバを考え、U数や冷却性を計算し可能な限り搭載できるサーバラックです。

HPCT YSR Series

https://archive-lib.hpctech.co.jp/hardware/hpct-ysr-series.html

UPS - PDU

管理ノードとスイッチ、ストレージ等を無停電電源装置で守ります。

無停電電源装置 - APC Smart-UPS

https://archive-lib.hpctech.co.jp/hardware/apc-smart-ups.html

設備投資は計画的に

計算リソースのサイジングは、常にソフトウェア・ハードウェア両方のキャッチアップができていないと難しい課題です。「なんとなくで買ったが性能が足らなくて1台無駄になった」や「いわれるままに買ったものの性能を活かしきれない」といった声をよく耳にします。

Mini-POD シリーズは高性能な計算環境を段階的に拡張することができ、買い切りなのでクラウドのように割高な月額使用料がありません。

HPCテックは計算リソースを扱い易いかたちで使い倒す事でコストパフォーマンスが最大化させられると考えており、普段使いの道具として扱える計算機が AI や HPC への参入ハードルを下げます。

詳しくは担当営業までお気軽にお問合せください。

製品案内

- NVIDIA Tensor Core GPU

- NVIDIA H100 NEW

- A800 40GB Active NEW

- NVIDIA A10

- NVIDIA A30

- NVIDIA A100

- NVIDIA V100s

- NVIDIA T4

- NVIDIA V100

- NVIDIA Quadro SERIES

- RTX 4500 Ada NEW

- RTX 4000 Ada NEW

- L40S NEW

- RTX 5000 Ada NEW

- RTX 4000 SFF Ada NEW

- RTX 6000 Ada NEW

- NVIDIA L40

- NVIDIA RTX A5500

- NVIDIA RTX A4500

- NVIDIA A40

- NVIDIA RTX A6000

- NVIDIA RTX A5000

- NVIDIA RTX A4000

- Quadro RTX8000 Passive

- Quadro RTX8000

- Quadro RTX6000

- Quadro GV100

- Quadro GP100

- Quadro P6000

- NVIDIA TITAN SERIES

- NVIDIA TITAN RTX

- NVIDIA TITAN V

- NVIDIA TITAN Xp

- NVIDIA TITAN Xp-SW

- NVIDIA GeForce SERIES

- GeForce RTX3090

- GeForce RTX2080Ti

- GeForce GTX1080Ti

- GeForce GTX1080

- GPUワークステーション

- HPCT WRSE31-4GP

- HPCT WR17as-4GP

- HPCT WR13as-4GP

- HPCT W117gs

- HPCT W116gs

- HPCT W216gs

- HPCT WR16gs

- HPCT WRSX42-4GP NEW

- HPCT WRSX31-4GP

- HPCT WRSX32-4GP

- HPCT WR26gs-Silent

- HPCT WR26gs

- GPUラックマウントサーバ

- HPCT RS2E41-4GP NEW

- HPCT RG2E42-4GPNEW

- HPCT RG2E31-4GP

- HPCT R217gg-4GP

- HPCT RG2E32-8GP

- HPCT R227gg-8GP

- HPCT RS4E42-8GP NEW

- HPCT RS4E32-8GP

- HPCT R427as-8GP

- HPCT R116gs

- HPCT RS1X32-4GP

- HPCT R126gs

- HPCT R126gs-4GP

- HPCT RS2X41-2GP NEW

- HPCT RS2X42-4GP NEW

- HPCT RS2X32-6GP

- HPCT R226gs

- HPCT R426gs-8GP

- HPCT RS4X42-8GP NEW

- HPCT RS4X32-10GP

- HPCT R426gs-10GP

- GPUラックマウントサーバ

- for NVLink - NVIDIA DGX H100 NEW

- NVIDIA DGX A100

- HPCT RS2E32-4GN

- HPCT R227as-4GN

- HPCT RS4X42-4GN NEW

- HPCT RS2X32-4GN

- HPCT R126gs-4GN

- HPCT RS4E32-8GN

- HPCT R427as-8GN

- HPCT RS4X32-8GN

- HPCT R426gs-8GN

- HPCT RX26gs-16GN

- 販売終息製品

- サービス

- セットアップサービス

- DL クラスタ管理

- ベンチマーク情報

- NVIDIA GPU CLOUD

- GPUアプリケーション

- 化学・量子化学

- AMBER

- GROMACS

- NAMD

- 量子化学

- GAMESS-UK

- GAMESS-US

- 物質科学

- VASP

- 数値解析

- MATLABS

- Mathematica

- 数値流体力学

- Ansys Fluent

- 構造力学

- Abaqus

- Ansys Mechanical

- LS-DYNA

- MSC Nastran

- MSC Marc

- 電磁界

- CST Microwave

Studio(MWS) - JMAG

- タンパク質構造解析

- AlphaFold

- RELION

- GPUユーザレポート

- GPU TEST DRIVE CENTER

- GPUテストドライブとは

- HPCT-Trial

- 導入事例

- 会社情報

- サポート

- お取引・お問い合わせ