GPU Solution:NVIDIA GPU

- トップページ

- 製品案内

- GPUラインナップ

- NVIDIA GPU

- NVIDIA A100

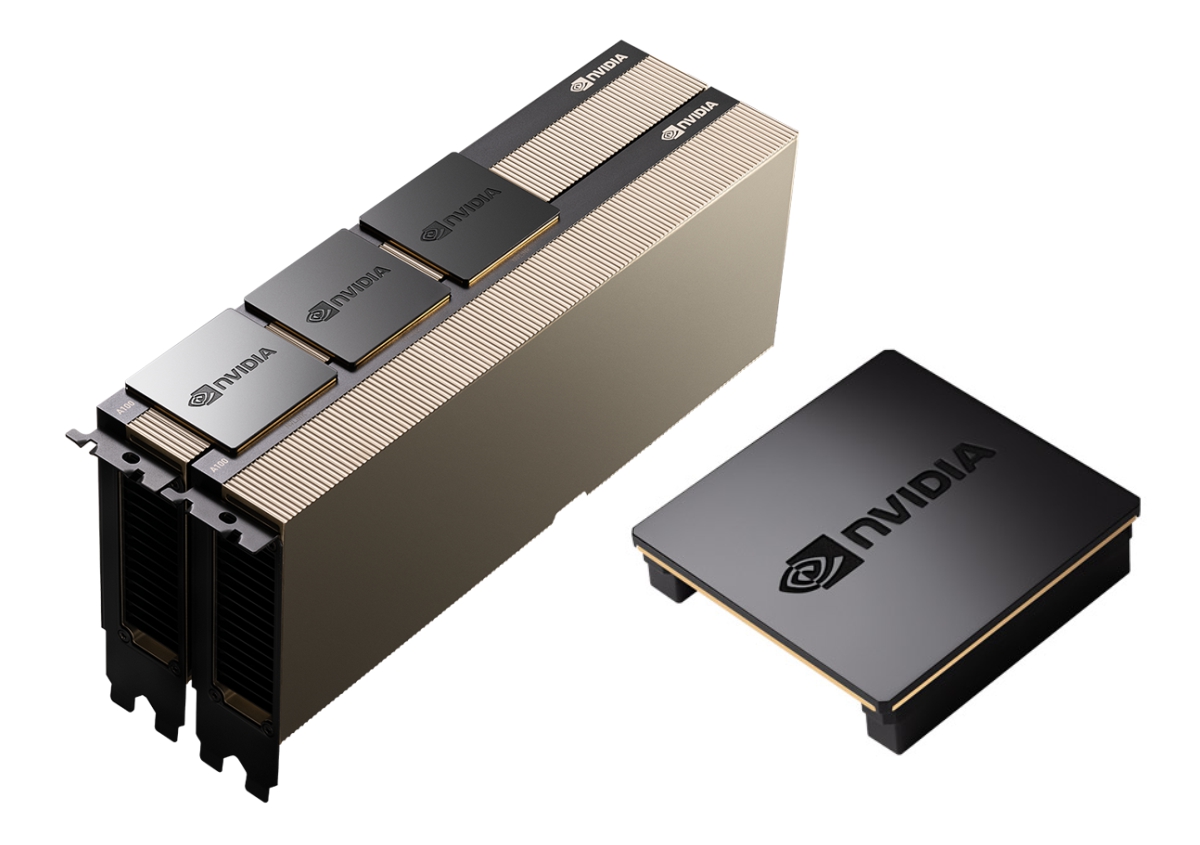

NVIDIA A100 Tensor Core GPU

NVIDIA A100 Tensor Core GPU PCI-Express 接続版にメモリ容量を 2倍にした NVIDIA A100-PCIe 80GB HBM2e が追加されました。メモリ帯域は約 25%拡張され 1,935GB/sに達し、今まで以上のモデルやデータセットにも対応します。

NVIDIA A100-PCIe 80GB HBM2e と NVIDIA A100-PCIe 40GB HBM2 はあらゆる規模で高速化を実現し、AI、データ分析、HPC に最高のパフォーマンスをもたらします。

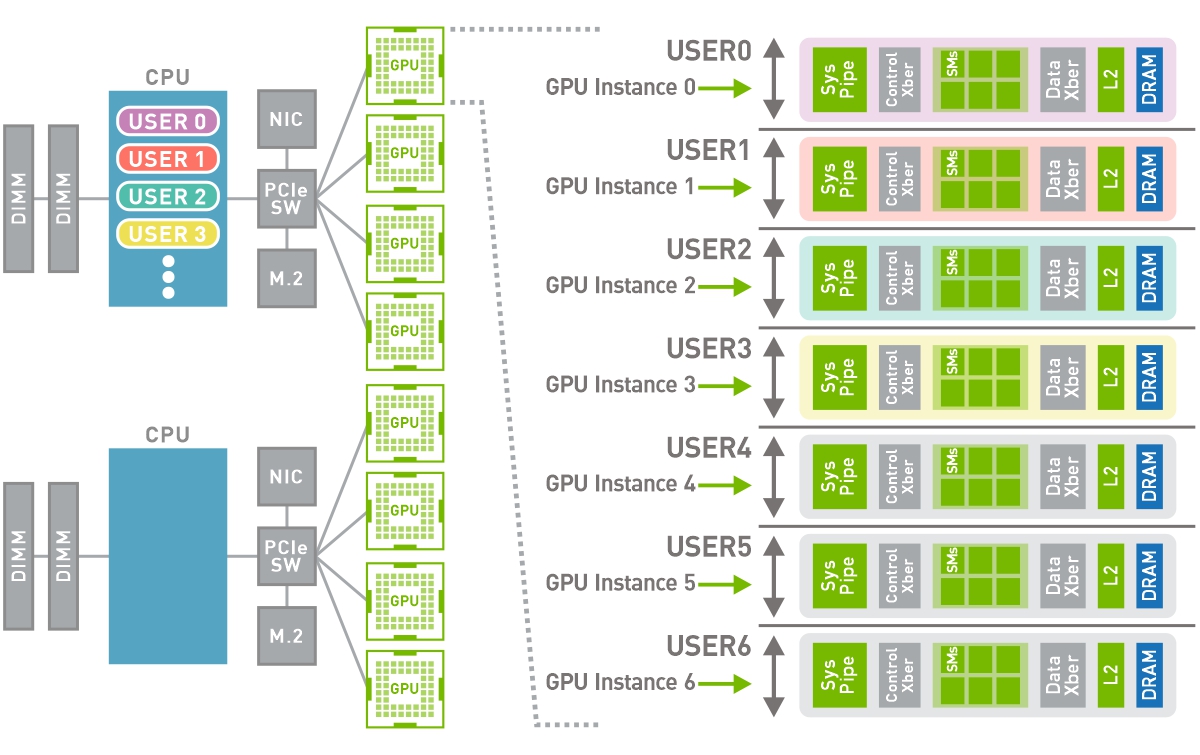

NVIDIA Ampere アーキテクチャで設計された NVIDIA A100 は、前世代と比較して最大 20倍のパフォーマンスを発揮し、7つの GPUインスタンスに分割して変化する需要に合わせて動的に調整できます。

製品仕様

|

NVIDIA A100 |

NVIDIA A100 |

|||

|

|

|||

| Peak FP64 | 9.7 TF | |||

| Peak FP64 Tensor Core | 19.5 TF | |||

| Peak FP32 | 19.5 TF | |||

| Peak TF32 Tensor Core | 156 TF | 312 TF* | |||

| Peak BFLOAT16 Tensor Core | 312 TF | 624 TF* | |||

| Peak FP16 Tensor Core | 312 TF | 624 TF* | |||

| Peak INT8 Tensor Core | 624 TOPS | 1,248 TOPS* | |||

| Peak INT4 Tensor Core | 1,248 TOPS | 2,496 TOPS* | |||

| GPU Memory | 40 GB | 80 GB | 40 GB | 80 GB |

| GPU Memory Bandwidth | 1,555 GB/s | 2,039 GB/s | 1,555 GB/s | 1,935 GB/s |

| Interconnect | NVIDIA NVLink 600 GB/s** PCIe Gen4 64 GB/s |

NVIDIA NVLink 600 GB/s** PCIe Gen4 64 GB/s |

||

| Multi-instance GPUs |

Up to 7MIGs @5GB |

Up to 7MIGs @10GB | Up to 7MIGs @5GB | Up to 7MIGs @10GB |

| Form Factor | SXM | PCIe |

||

| Max TDP Power | 400W | 250W | 300W | |

* With sparsity

** SXM GPUs via HGX A100 server boards, PCIe GPUs via NVLink Bridge for up to 2-GPUs

ディープラーニング トレーニング

対話型 AIといった次のレベルの課題に挑む AIモデルは、爆発的に複雑化しており、モデルのトレーニングには、大規模な計算処理能力とスケーラビリティが必要になります。

NVIDIA A100の Tensorコア と Tensor Float (TF32) を利用することで、NVIDIA Voltaと比較して最大 20倍のパフォーマンスがコードを変更することなく得られます。加えて、Automatic Mixed Precisionと FP16の活用でさらに 2倍の高速化が可能になります。

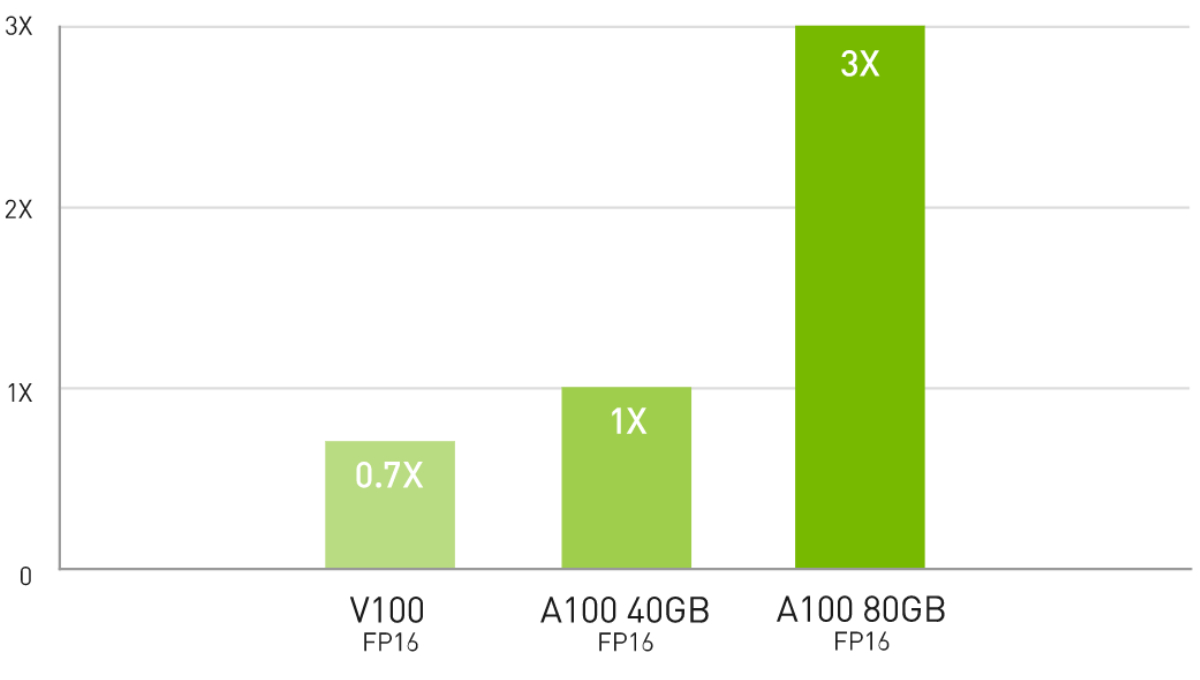

最大級のモデルで最大 3倍高速な AIトレーニング

DLRM トレーニング

DLRM on HugeCTR framework, precision = FP16 | NVIDIA A100 80GB batch size = 48 | NVIDIA A100 40GB batch size = 32 | NVIDIA V100 32GB batch size = 32.

ディープラーニング推論

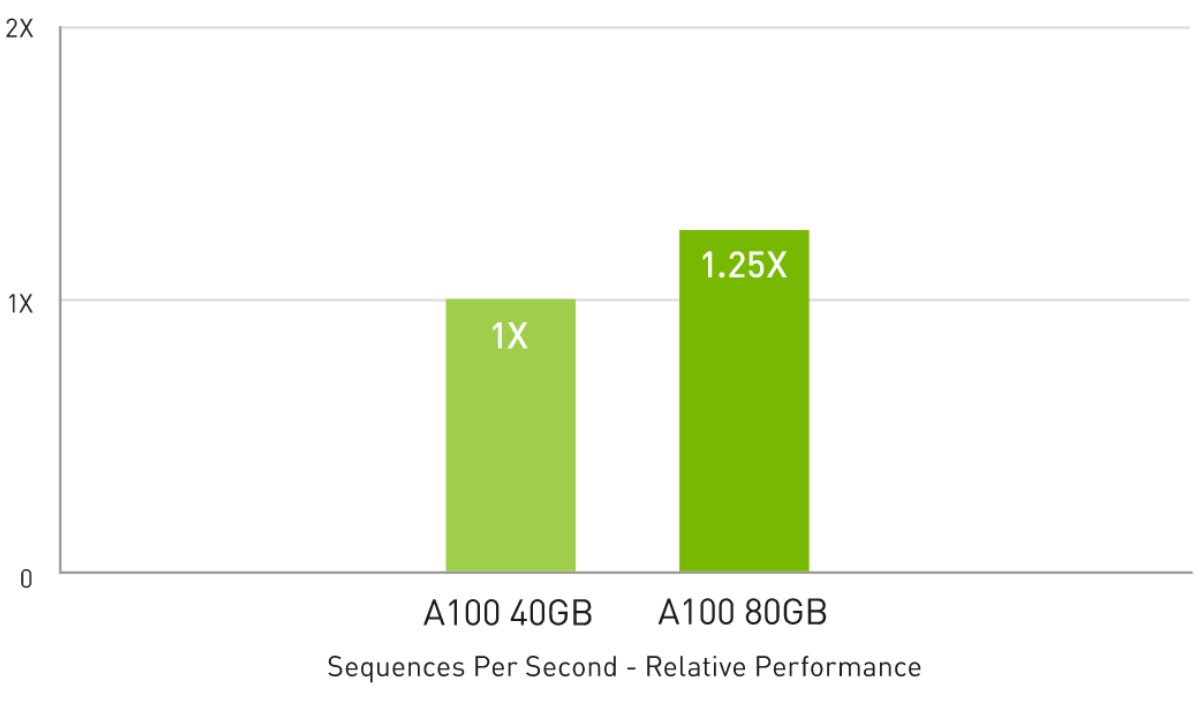

A100には、推論ワークロードを最適化する画期的な機能が導入されています。FP32から INT4まであらゆる精度を加速します。マルチインスタンス GPU (MIG) テクノロジにより、1個の A100で複数のネットワークを同時に動作できるため、コンピューティングリソースの使用率が最適化されます。また、構造化スパース性により、A100による数々の推論性能の高速化に加え、最大 2倍のパフォーマンスがもたらされます。メモリ容量の大きな A100 80GBでは各 MIGのサイズが 2倍になり、自動音声認識用の RNN-Tといった、バッチサイズが制約された非常に複雑なモデルでは、A100 40GBに比べて最大 1.25倍のスループットが得られます。

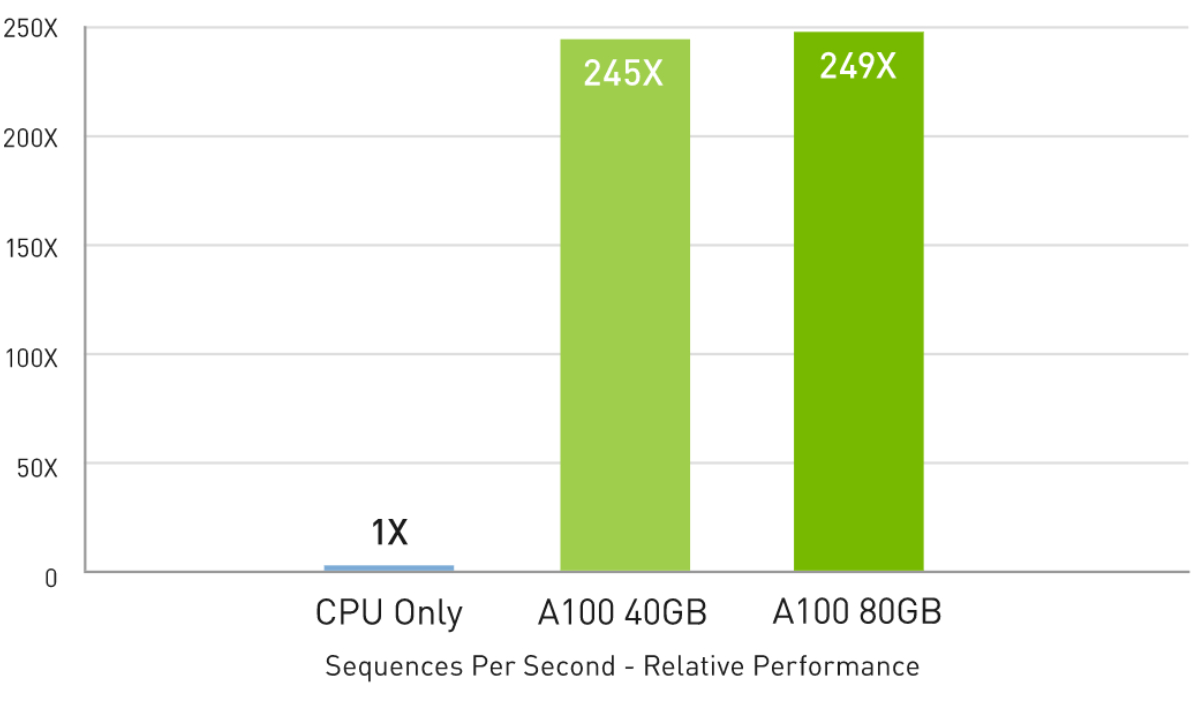

CPUと比較して最大 249倍高速な AI推論パフォーマンス

BERT 大規模推論

BERT-Large Inference | CPU only: Dual Xeon Gold 6240 @ 2.60 GHz, precision = FP32, batch size = 128 | V100: NVIDIA TensorRT™ (TRT) 7.2, precision = INT8, batch size = 256 | A100 40GB and 80GB, batch size = 256, precision = INT8 with sparsity.

A100 40GBと比較して最大 1.25倍高速な AI推論パフォーマンス

RNN-T 推論:単一のストリーム

MLPerf 0.7 RNN-T measured with (1/7) MIG slices. Framework: TensorRT 7.2, dataset = LibriSpeech, precision = FP16.

ハイパフォーマンス コンピューティング

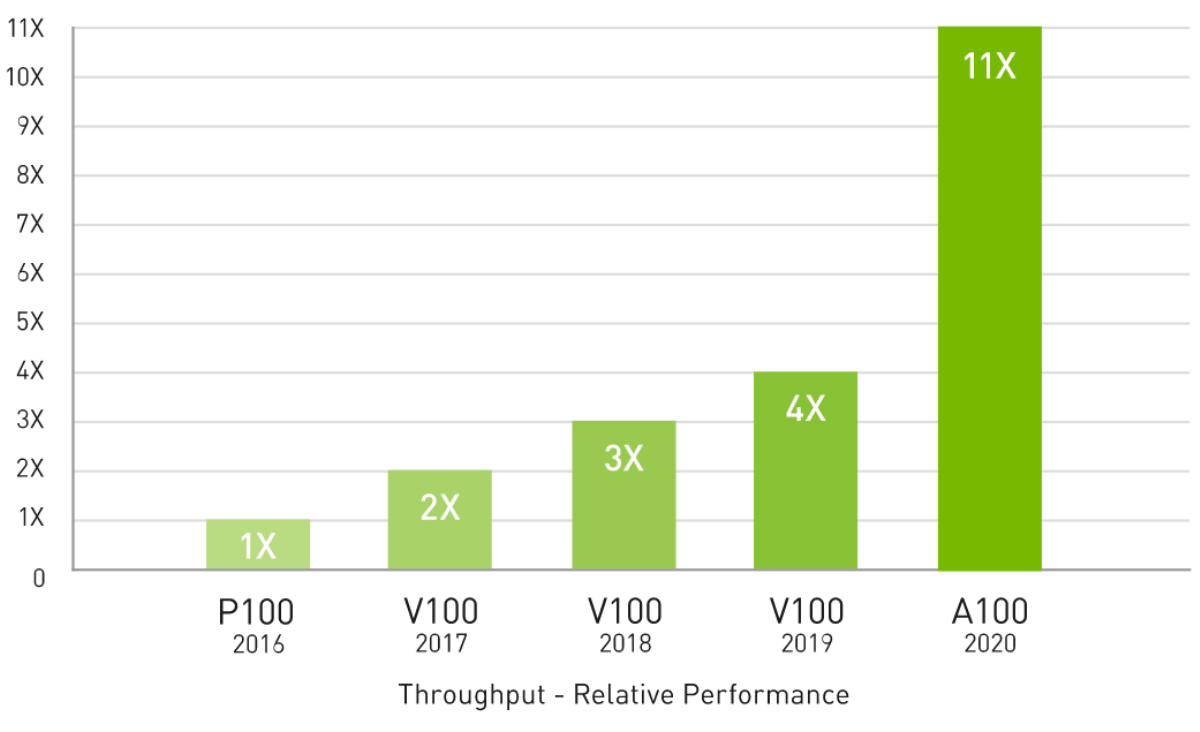

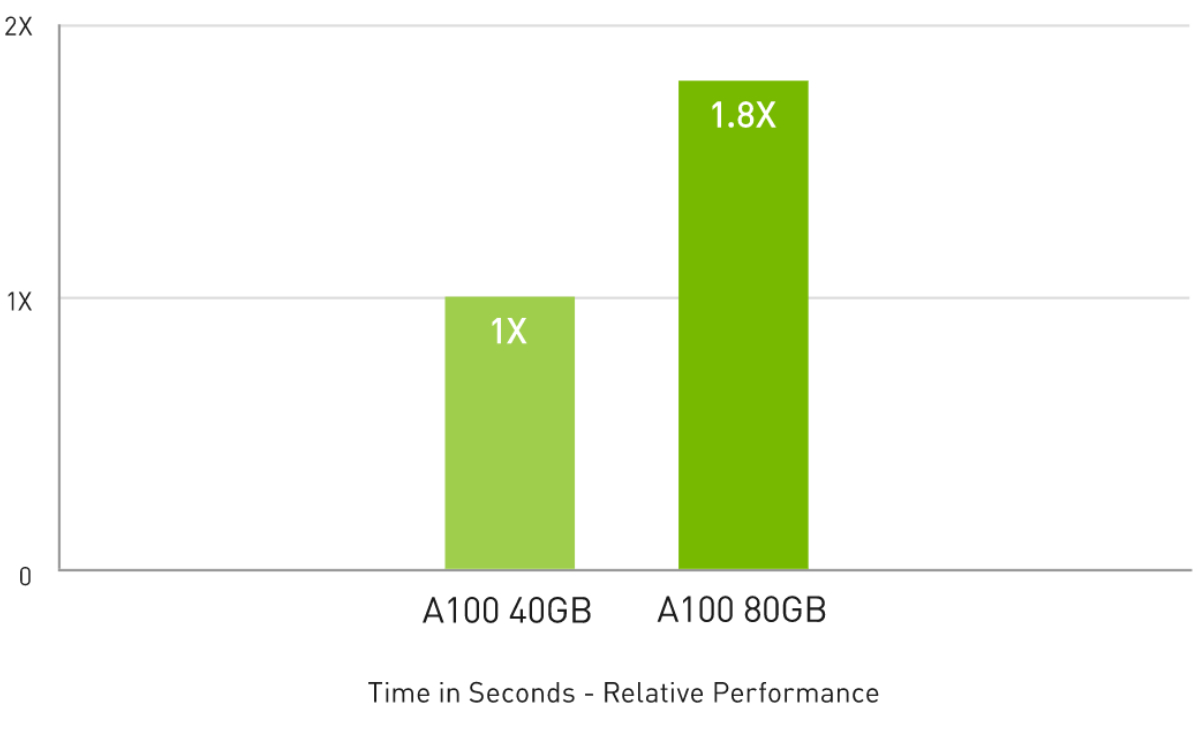

科学者たちは日々、私たちを取り巻いている世界をより良く理解し、その謎を解き明かすためのシミュレーションに関心を向けています。NVIDIA A100は、Tensorコアを導入することで HPCパフォーマンスの飛躍を実現しています。80GBのGPUメモリとNVIDIA A100を組み合わせることで、研究者は10時間かかる倍精度シミュレーションをわずか4時間たらずに短縮できます。HPCアプリケーションで TF32を活用すれば、単精度の密行列積演算のスループットが最大 11倍向上します。

大規模データセットを扱う HPC アプリケーションでは、メモリが追加された A100 80GBにより、マテリアルシミュレーションの Quantum Espressoにおいて最大 2倍のスループットの増加を実現します。この膨大なメモリ量とメモリ帯域幅により、A100 80GBは次世代のワークロードに最適なプラットフォームとなっています。

4年間で 11倍の HPCパフォーマンス

上位 HPCアプリケーション

Geometric mean of application speedups vs. P100: Benchmark application: Amber [PME-Cellulose_NVE], Chroma [szscl21_24_128], GROMACS [ADH Dodec], MILC [Apex Medium], NAMD [stmv_nve_cuda], PyTorch (BERT-Large Fine Tuner], Quantum Espresso [AUSURF112-jR]; Random Forest FP32 [make_blobs (160000 x 64 : 10)], TensorFlow [ResNet-50], VASP 6 [Si Huge] | GPU node with dual-socket CPUs with 4x NVIDIA P100, V100, or A100 GPUs.

HPCアプリケーションで最大 1.8倍高速なパフォーマンス

Quantum Espresso

Quantum Espresso measured using CNT10POR8 dataset, precision = FP64.

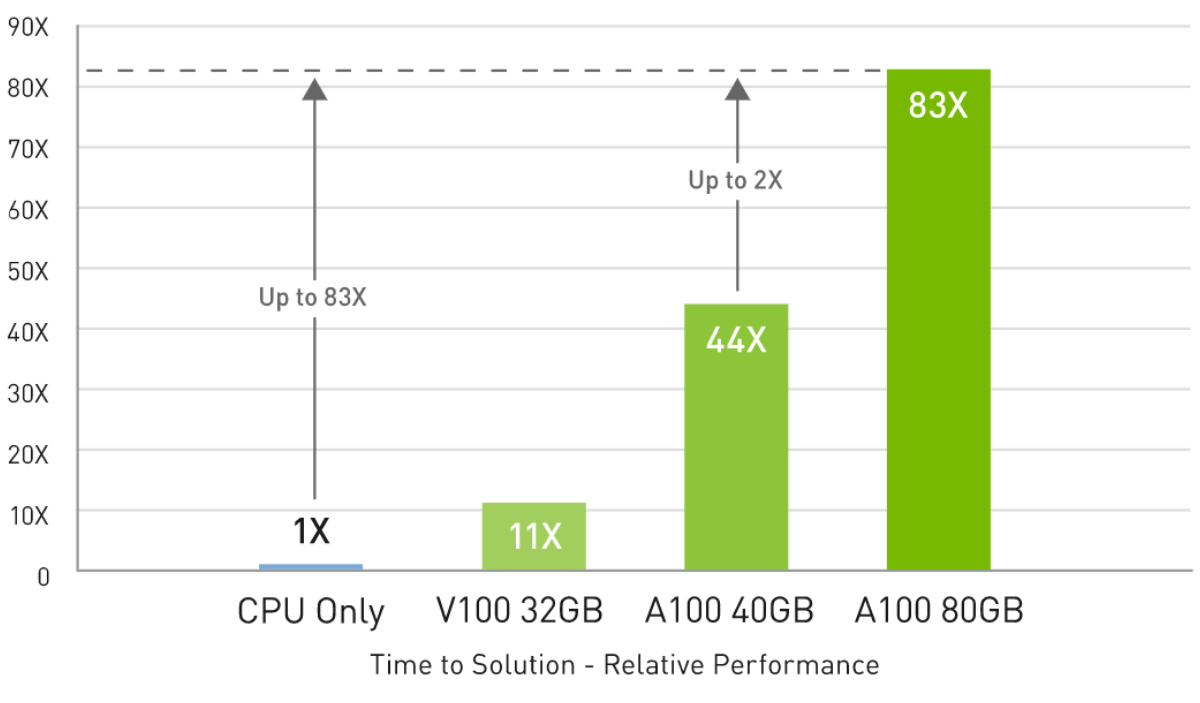

ハイパフォーマンス データ分析

A100 80GBはビッグデータ分析ベンチマークで、CPUの 83倍高いスループット、A100 40GBに対しては 2倍高いスループットでインサイトをもたらします。データセットサイズが爆発的に増える今のワークロードに最適です。

ビッグデータ分析ベンチマークで CPUより最大 83倍、A100 40GBより 2倍高速

Big data analytics benchmark | 30 analytical retail queries, ETL, ML, NLP on 10TB dataset | CPU: Intel Xeon Gold 6252 2.10 GHz, Hadoop | V100 32GB, RAPIDS/Dask | A100 40GB and A100 80GB, RAPIDS/Dask/BlazingSQL

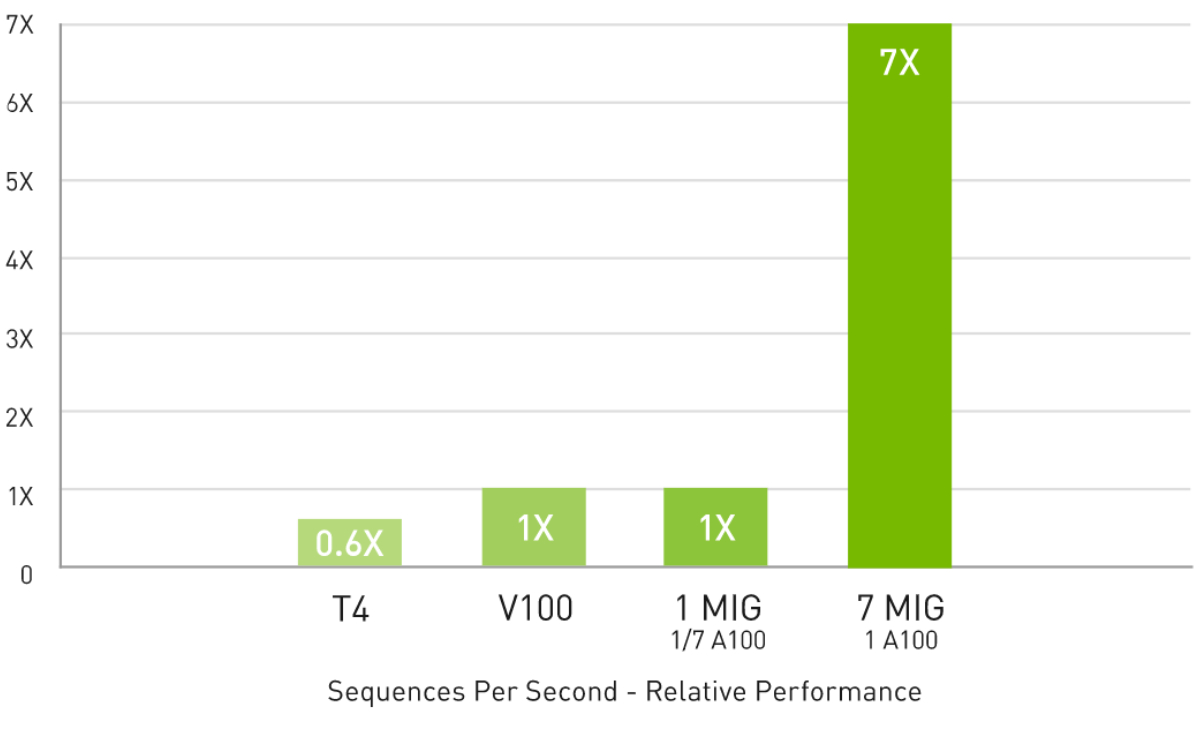

企業で効率的に利用

A100と MIGの組み合わせにより、GPU活用インフラストラクチャを最大限に利用できます。MIGを利用することで、A100 GPUを 7つもの独立したインスタンスに分割できます。複数のユーザーが GPUアクセラレーションを利用できます。A100 40GBでは、各 MIGインスタンス に最大 5GBまで割り当てることができ、A100 80GBではメモリ容量が増えたことで、そのサイズは 2倍の 10GBになります。

マルチインスタンス GPU (MIG) による 7倍の推論スループット

BERT 大規模推論

BERT Large Inference | NVIDIA TensorRT™ (TRT) 7.1 | NVIDIA T4 Tensor Core GPU: TRT 7.1, precision = INT8, batch size = 256 | V100: TRT 7.1, precision = FP16, batch size = 256 | A100 with 1 or 7 MIG instances of 1g.5gb: batch size = 94, precision = INT8 with sparsity.

CSP Multi-Instance GPU(MIG)

NVIDIA A100-PCIe 用 NVLINK BRIDGE - 2Way 2Slot

NVIDIA A100 Tensor Core GPU Architecture - WHITEPAPER

NVIDIA A100 Tensor Core GPU Architecture - WHITEPAPER

製品案内

- NVIDIA Tensor Core GPU

- NVIDIA H100 NEW

- A800 40GB Active NEW

- NVIDIA A10

- NVIDIA A30

- NVIDIA A100

- NVIDIA V100s

- NVIDIA T4

- NVIDIA V100

- NVIDIA Quadro SERIES

- RTX 4500 Ada NEW

- RTX 4000 Ada NEW

- L40S NEW

- RTX 5000 Ada NEW

- RTX 4000 SFF Ada NEW

- RTX 6000 Ada NEW

- NVIDIA L40

- NVIDIA RTX A5500

- NVIDIA RTX A4500

- NVIDIA A40

- NVIDIA RTX A6000

- NVIDIA RTX A5000

- NVIDIA RTX A4000

- Quadro RTX8000 Passive

- Quadro RTX8000

- Quadro RTX6000

- Quadro GV100

- Quadro GP100

- Quadro P6000

- NVIDIA TITAN SERIES

- NVIDIA TITAN RTX

- NVIDIA TITAN V

- NVIDIA TITAN Xp

- NVIDIA TITAN Xp-SW

- NVIDIA GeForce SERIES

- GeForce RTX3090

- GeForce RTX2080Ti

- GeForce GTX1080Ti

- GeForce GTX1080

- GPUワークステーション

- HPCT WRSE31-4GP

- HPCT WR17as-4GP

- HPCT WR13as-4GP

- HPCT W117gs

- HPCT W116gs

- HPCT W216gs

- HPCT WR16gs

- HPCT WRSX42-4GP NEW

- HPCT WRSX31-4GP

- HPCT WRSX32-4GP

- HPCT WR26gs-Silent

- HPCT WR26gs

- GPUラックマウントサーバ

- HPCT RS2E41-4GP NEW

- HPCT RG2E42-4GPNEW

- HPCT RG2E31-4GP

- HPCT R217gg-4GP

- HPCT RG2E32-8GP

- HPCT R227gg-8GP

- HPCT RS4E42-8GP NEW

- HPCT RS4E32-8GP

- HPCT R427as-8GP

- HPCT R116gs

- HPCT RS1X32-4GP

- HPCT R126gs

- HPCT R126gs-4GP

- HPCT RS2X41-2GP NEW

- HPCT RS2X42-4GP NEW

- HPCT RS2X32-6GP

- HPCT R226gs

- HPCT R426gs-8GP

- HPCT RS4X42-8GP NEW

- HPCT RS4X32-10GP

- HPCT R426gs-10GP

- GPUラックマウントサーバ

- for NVLink - NVIDIA DGX H100 NEW

- NVIDIA DGX A100

- HPCT RS2E32-4GN

- HPCT R227as-4GN

- HPCT RS4X42-4GN NEW

- HPCT RS2X32-4GN

- HPCT R126gs-4GN

- HPCT RS4E32-8GN

- HPCT R427as-8GN

- HPCT RS4X32-8GN

- HPCT R426gs-8GN

- HPCT RX26gs-16GN

- 販売終息製品

- サービス

- セットアップサービス

- DL クラスタ管理

- ベンチマーク情報

- NVIDIA GPU CLOUD

- GPUアプリケーション

- 化学・量子化学

- AMBER

- GROMACS

- NAMD

- 量子化学

- GAMESS-UK

- GAMESS-US

- 物質科学

- VASP

- 数値解析

- MATLABS

- Mathematica

- 数値流体力学

- Ansys Fluent

- 構造力学

- Abaqus

- Ansys Mechanical

- LS-DYNA

- MSC Nastran

- MSC Marc

- 電磁界

- CST Microwave

Studio(MWS) - JMAG

- タンパク質構造解析

- AlphaFold

- RELION

- GPUユーザレポート

- GPU TEST DRIVE CENTER

- GPUテストドライブとは

- HPCT-Trial

- 導入事例

- 会社情報

- サポート

- お取引・お問い合わせ