GPU Solution:NVLink

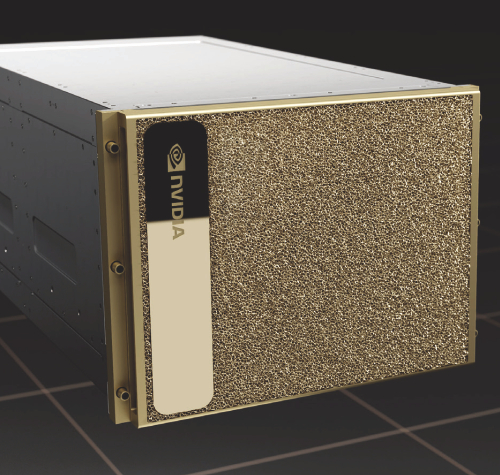

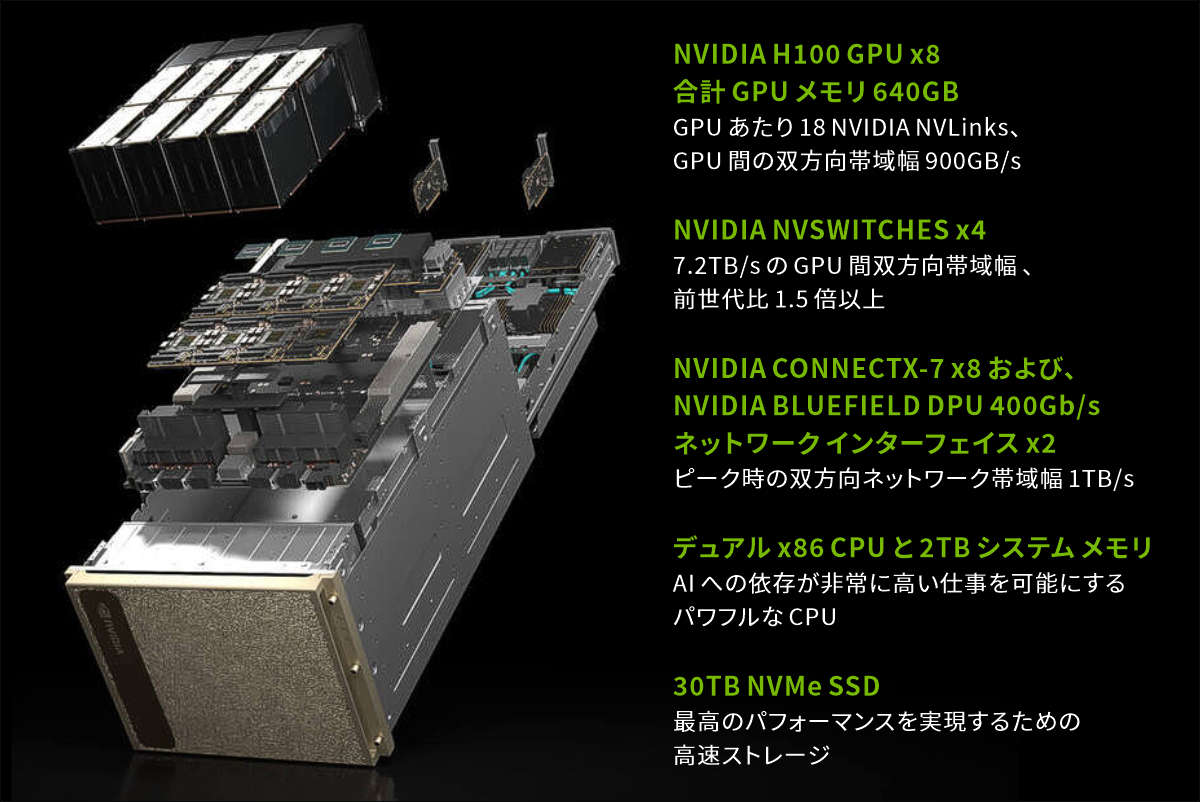

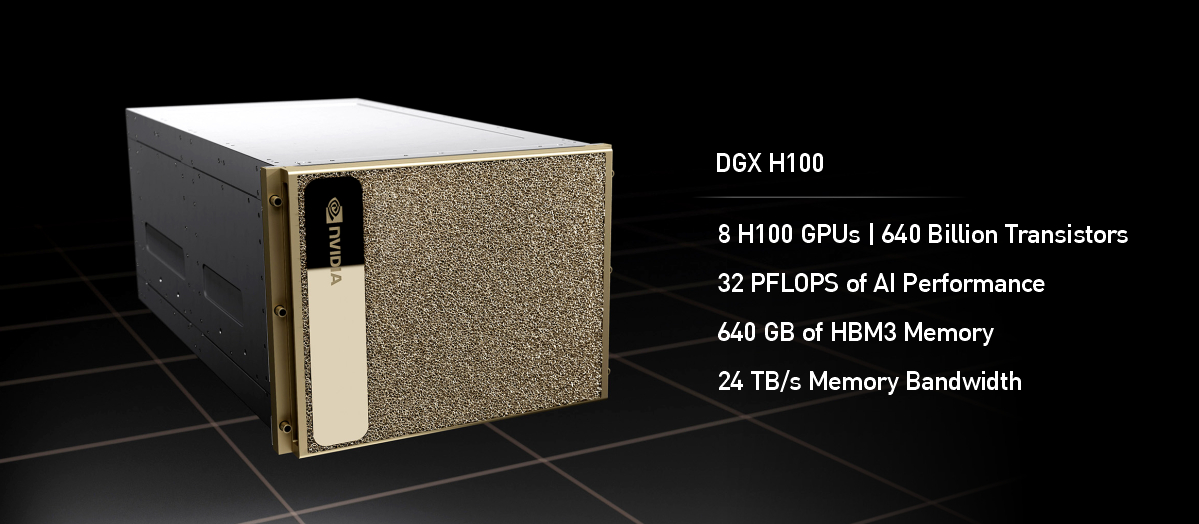

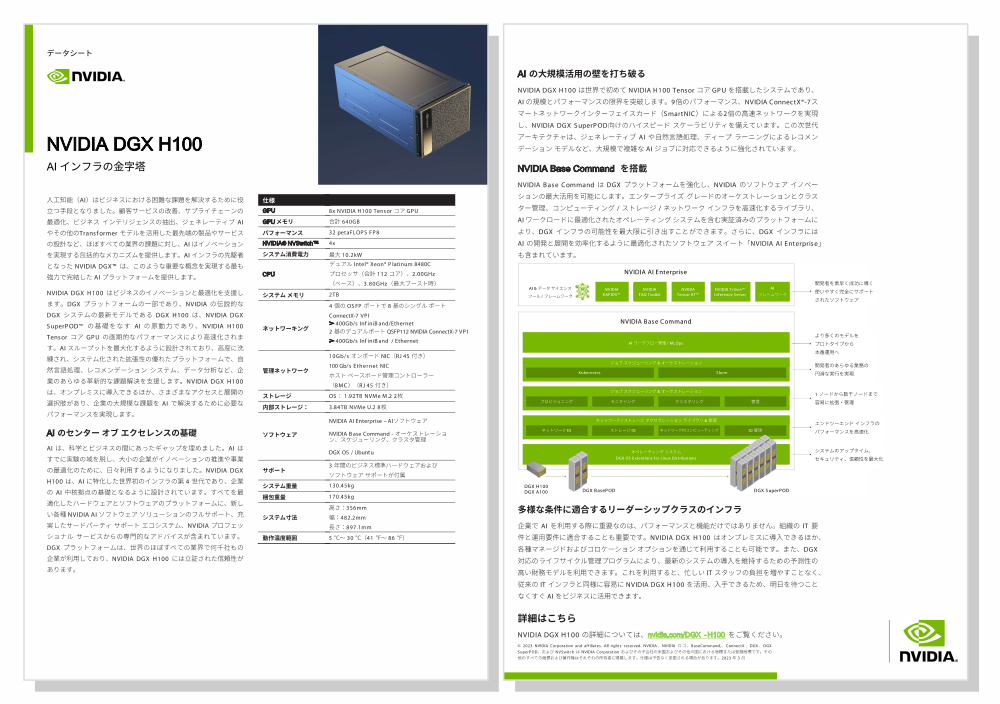

NVIDIA DGX H100

NVIDIA DGX H100 : エンタープライズ AI システム

第4世代 NVIDIA DGX H100 は NVIDIA H100 Tensor Core GPU を搭載した AI システムです。AI のスループットを最大化するように設計されており、システム化され、高度に洗練された拡張可能なプラットフォームを企業に提供することで、自然言語処理・レコメンドシステム・データ分析など様々な分野を支援します。また、完全に最適化されたハードウェアとソフトウェアのプラットフォームとして、全ての領域に対しフルサポートされます。そこには、NVIDIA の AI ソフトウェアソリューションやサードパーティ・サポートの豊富なエコシステム、NVIDIA プロフェッショナルサービスによる専門家のアドバイスなどが含まれます。

詳しくは担当までお問い合わせください。 お問い合わせフォーム TEL:03-5643-2681 ![]()

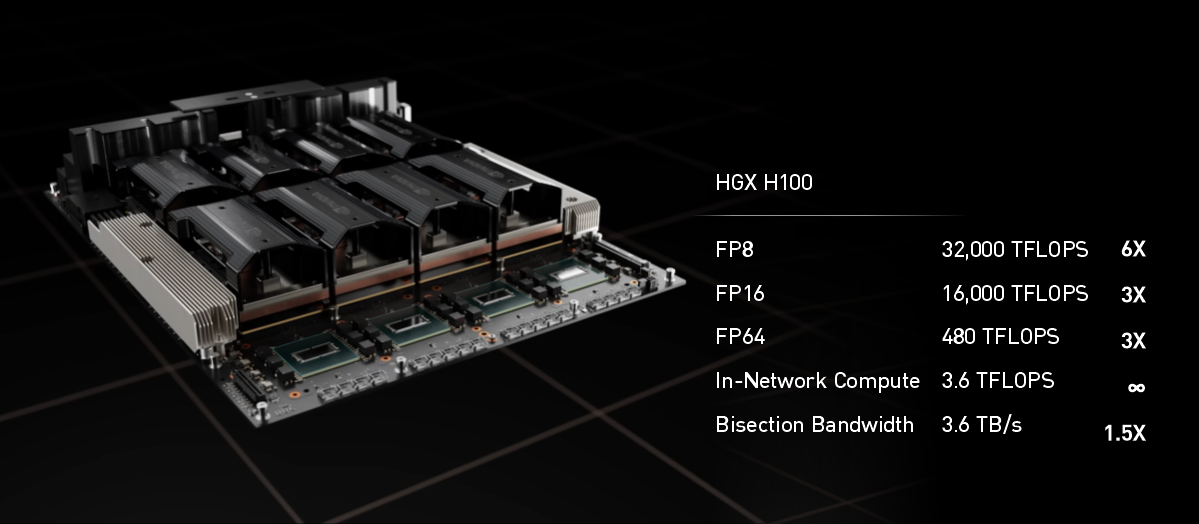

Hopperアーキテクチャ NVIDIA H100 GPU を 8基搭載

32petaFLOPS の FP8パフォーマンスを誇る AIプラットフォーム

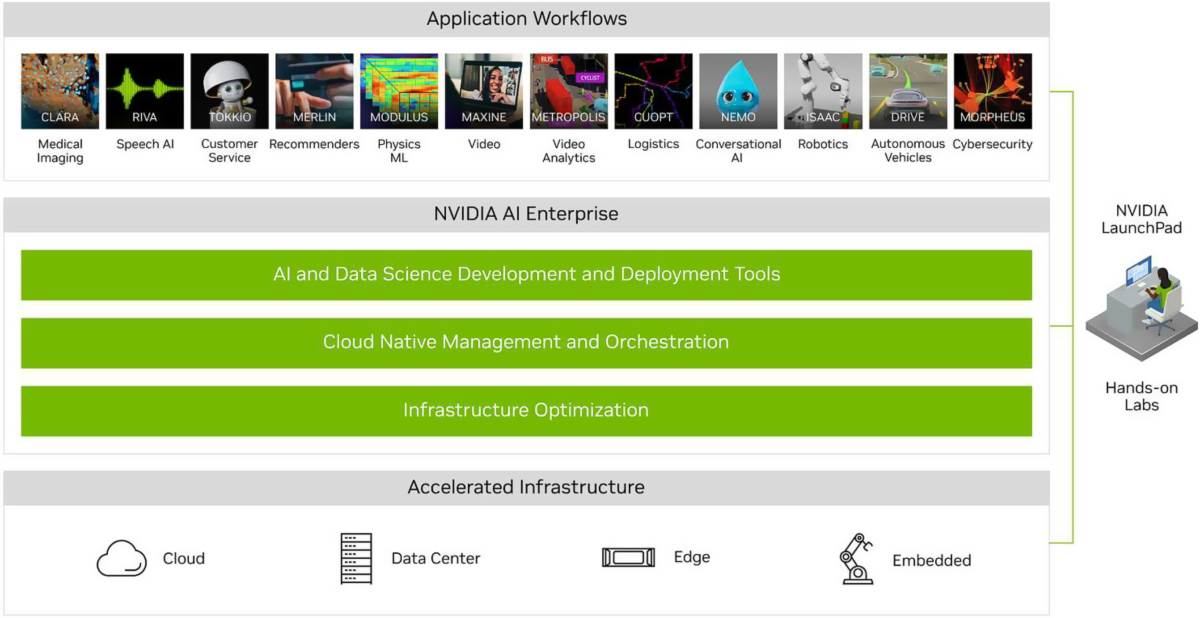

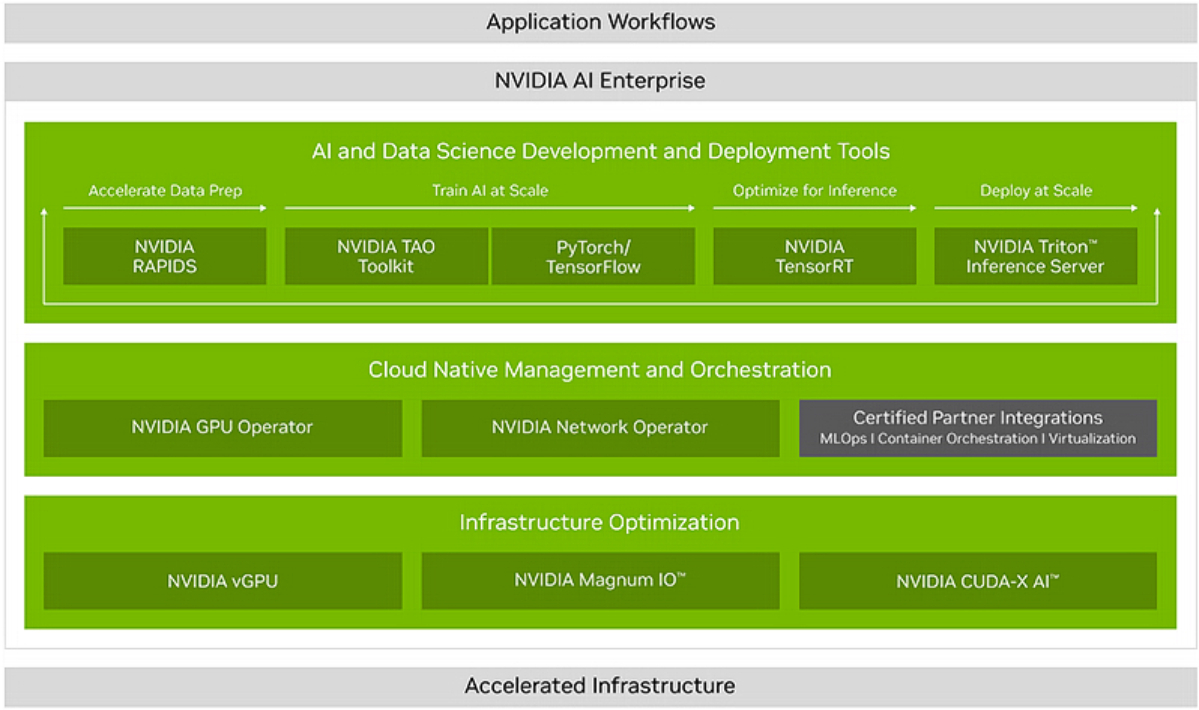

NVIDIA AI Enterprise - AI Enterprise ソフトウェア スイート

AI の開発と展開に最適化された、クラウドネイティブな AI およびデータ分析ソフトウェア スイートで、企業における AI 導入の体制を整えましょう。NVIDIA AI Enterprise は、対話型 AI 用 NVIDIA® Riva、レコメンダー用 NVIDIA Merlin™、医用画像処理用 NVIDIA Clara™ など、豊富なフレームワークで構成されたライブラリで構築されたアプリケーションに不可欠な、NVIDIA AI プラットフォームのオペレーティング システムです。

DGX ソフトウェアバンドルには、合理化された AI 開発および展開のための NVIDIA AI Enterprise と、エンタープライズサポートが含まれています。

AI の価値を短期間で引き出す。

AI 実務者のための業界最高水準の開発ツールとフレームワーク、および IT 専門家のための信頼できる管理とオーケストレーションにより、優れた処理能力、可用性、セキュリティを確保します。

NVIDIA DGX H100 : SYSTEM SPECIFICATIONS

| NVIDIA DGX H100 | NVIDIA DGX A100 | ||

| GPU | NVIDIA H100 Tensor Core GPU 80GB x8 |

NVIDIA A100 Tensor Core GPU 80GB x8 |

|

| GPU Memory | 640GB total | 640GB total | |

| Performance | 32 petaFLOPS FP8 | 5petaFLOPS AI 10petaOPS INT8 |

|

| NVIDIA NVSwitches | 4 | 6 | |

| System Power Usage | ~10.2kW max | 6.5kW max | |

| CPU | Dual x86 | Dual AMD rome 7742 (128Core Total, 2.25GHz) |

|

| System Memory | 2TB | 2TB | |

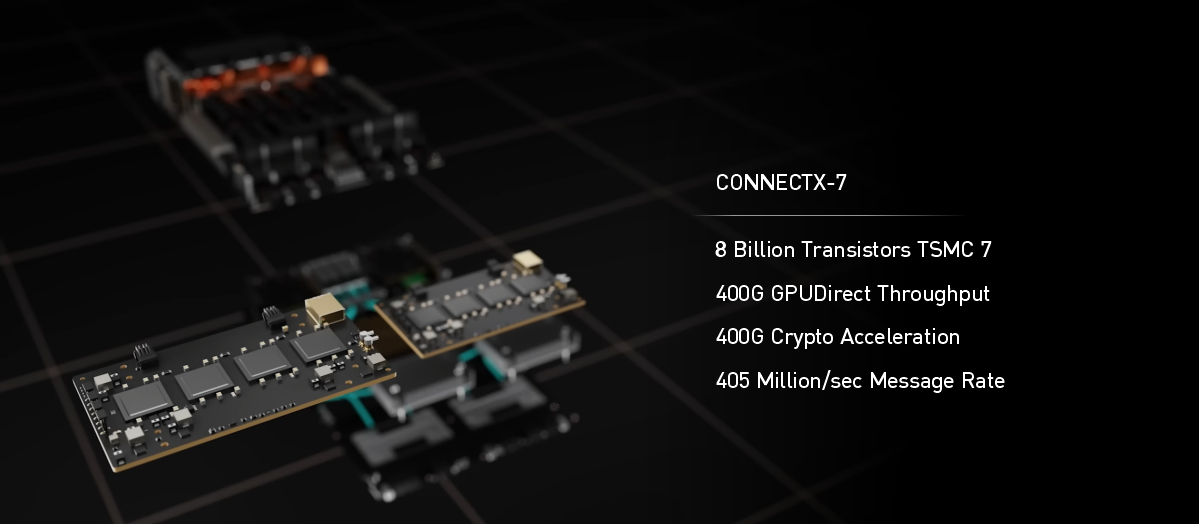

| Networking | 4x OSFP ports serving 8x single-port NVIDIA ConnectX-7 VPI 400 Gb/s InfiniBand or 200 Gb/s Ethernet2x dual-port NVIDIA ConnectX-7 VPI 1x 400 Gb/s InfiniBand 1x 200 Gb/s Ethernet |

8x Single-Port Mellanox ConnectX-6 VPI 200Gb/s HDR InfiniBand 2x Dual-Port Mellanox ConnectX-6 VPI 10/25/50/100/200 Gb/s Ethernet |

|

| Management network | 10 Gb/s onboard NIC with RJ45 50 Gb/s Ethernet optional NIC Host baseboard management controller (BMC) with RJ45 |

||

| Storage |

OS: 2x 1.9TB NVMe M.2 |

OS : 2x 1.92TB M.2 NVMe Drives Internal Storage : 30TB (8x 3.84TB) U.2 NVMe Drives |

|

| Software |

NVIDIA AI Enterprise - |

Ubuntu Linux OS Also supports: Red Hat Enterprise Linux CentOS |

|

| Support | Comes with 3-year business-standard hardware and software support | ||

| Operating temperature range |

5–30°C | ||

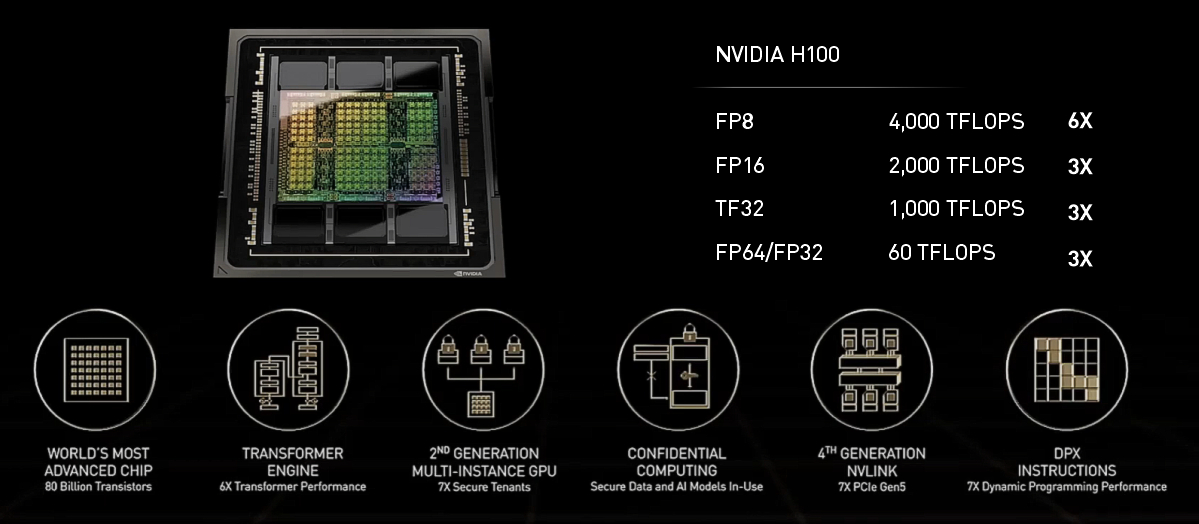

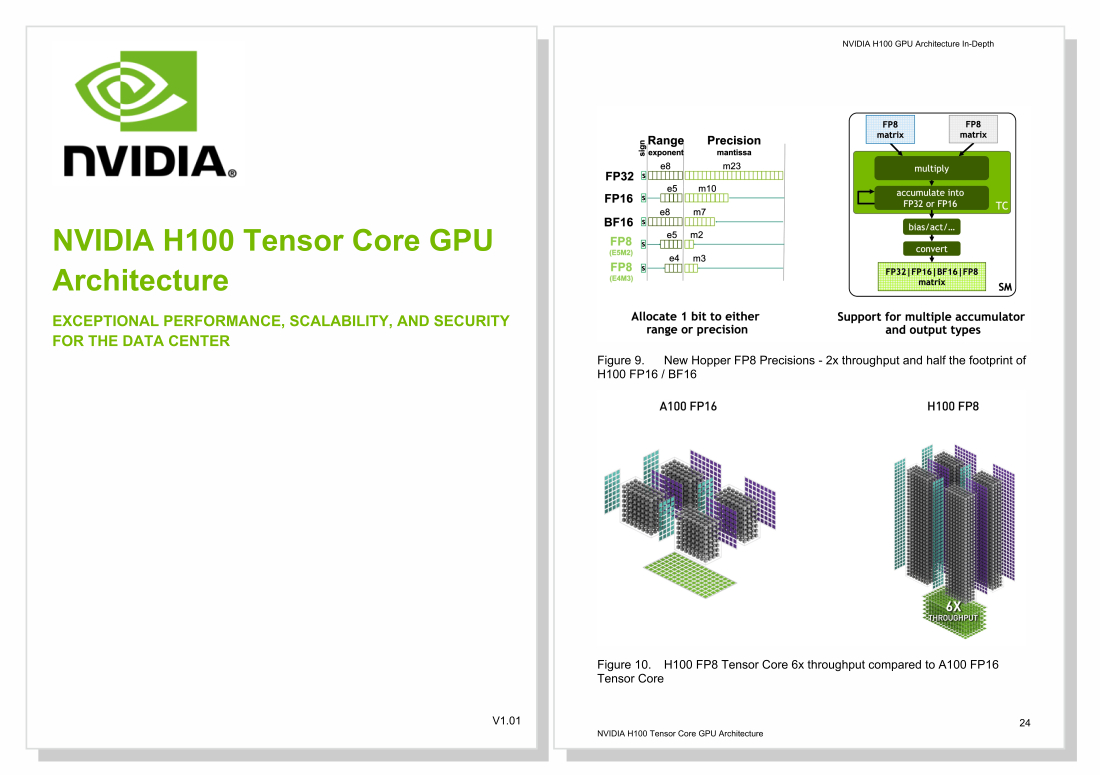

NVIDIA H100 Tensor Core GPU Architecture V1.04

NVIDIA DGX H100 – 日本語版

製品案内

- NVIDIA Tensor Core GPU

- NVIDIA H100 NEW

- A800 40GB Active NEW

- NVIDIA A10

- NVIDIA A30

- NVIDIA A100

- NVIDIA V100s

- NVIDIA T4

- NVIDIA V100

- NVIDIA Quadro SERIES

- RTX 4500 Ada NEW

- RTX 4000 Ada NEW

- L40S NEW

- RTX 5000 Ada NEW

- RTX 4000 SFF Ada NEW

- RTX 6000 Ada NEW

- NVIDIA L40

- NVIDIA RTX A5500

- NVIDIA RTX A4500

- NVIDIA A40

- NVIDIA RTX A6000

- NVIDIA RTX A5000

- NVIDIA RTX A4000

- Quadro RTX8000 Passive

- Quadro RTX8000

- Quadro RTX6000

- Quadro GV100

- Quadro GP100

- Quadro P6000

- NVIDIA TITAN SERIES

- NVIDIA TITAN RTX

- NVIDIA TITAN V

- NVIDIA TITAN Xp

- NVIDIA TITAN Xp-SW

- NVIDIA GeForce SERIES

- GeForce RTX3090

- GeForce RTX2080Ti

- GeForce GTX1080Ti

- GeForce GTX1080

- GPUワークステーション

- HPCT WRSE31-4GP

- HPCT WR17as-4GP

- HPCT WR13as-4GP

- HPCT W117gs

- HPCT W116gs

- HPCT W216gs

- HPCT WR16gs

- HPCT WRSX42-4GP NEW

- HPCT WRSX31-4GP

- HPCT WRSX32-4GP

- HPCT WR26gs-Silent

- HPCT WR26gs

- GPUラックマウントサーバ

- HPCT RS2E41-4GP NEW

- HPCT RG2E42-4GPNEW

- HPCT RG2E31-4GP

- HPCT R217gg-4GP

- HPCT RG2E32-8GP

- HPCT R227gg-8GP

- HPCT RS4E42-8GP NEW

- HPCT RS4E32-8GP

- HPCT R427as-8GP

- HPCT R116gs

- HPCT RS1X32-4GP

- HPCT R126gs

- HPCT R126gs-4GP

- HPCT RS2X41-2GP NEW

- HPCT RS2X42-4GP NEW

- HPCT RS2X32-6GP

- HPCT R226gs

- HPCT R426gs-8GP

- HPCT RS4X42-8GP NEW

- HPCT RS4X32-10GP

- HPCT R426gs-10GP

- GPUラックマウントサーバ

- for NVLink - NVIDIA DGX H100 NEW

- NVIDIA DGX A100

- HPCT RS2E32-4GN

- HPCT R227as-4GN

- HPCT RS4X42-4GN NEW

- HPCT RS2X32-4GN

- HPCT R126gs-4GN

- HPCT RS4E32-8GN

- HPCT R427as-8GN

- HPCT RS4X32-8GN

- HPCT R426gs-8GN

- HPCT RX26gs-16GN

- 販売終息製品

- サービス

- セットアップサービス

- DL クラスタ管理

- ベンチマーク情報

- NVIDIA GPU CLOUD

- GPUアプリケーション

- 化学・量子化学

- AMBER

- GROMACS

- NAMD

- 量子化学

- GAMESS-UK

- GAMESS-US

- 物質科学

- VASP

- 数値解析

- MATLABS

- Mathematica

- 数値流体力学

- Ansys Fluent

- 構造力学

- Abaqus

- Ansys Mechanical

- LS-DYNA

- MSC Nastran

- MSC Marc

- 電磁界

- CST Microwave

Studio(MWS) - JMAG

- タンパク質構造解析

- AlphaFold

- RELION

- GPUユーザレポート

- GPU TEST DRIVE CENTER

- GPUテストドライブとは

- HPCT-Trial

- 導入事例

- 会社情報

- サポート

- お取引・お問い合わせ