GPU Solution:NVIDIA GPU

- トップページ

- 製品案内

- GPUラインナップ

- NVIDIA GPU

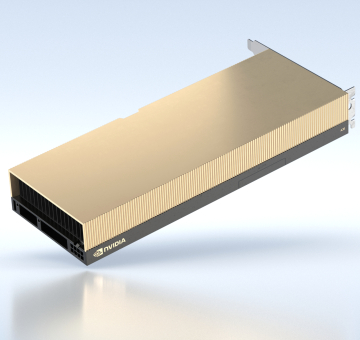

- NVIDIA A30

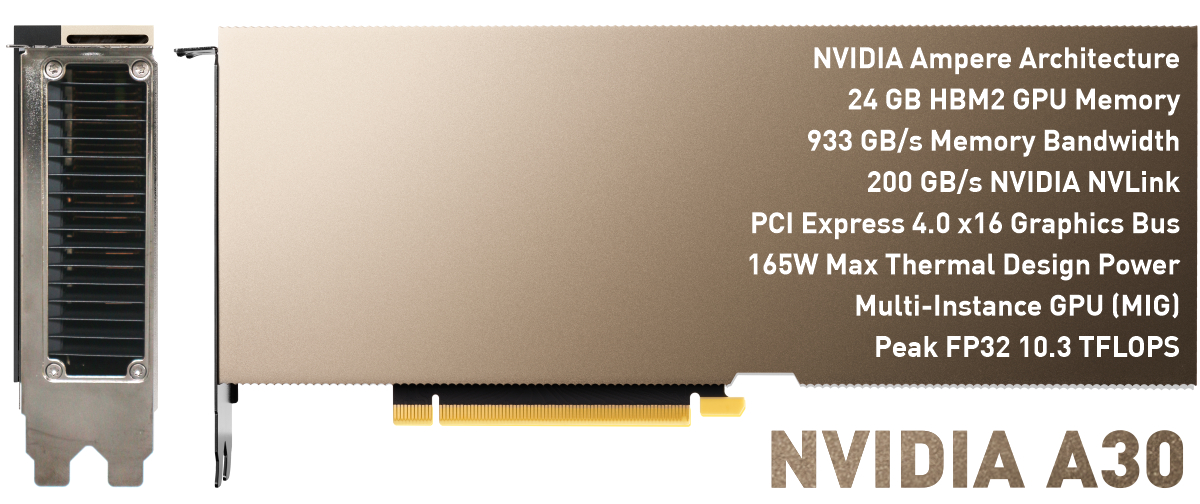

Ampere アーキテクチャ採用 AI 推論・HPC 用アクセラレータ

NVIDIA A30® は NVIDIA Ampere アーキテクチャの Tensor コアとマルチインスタンス GPU (MIG) で、大規模な AI 推論やハイパフォーマンスコンピューティング (HPC) アプリケーションといった多様なワークロードを安全に高速化します。

A30 搭載サーバは強力な演算能力や HBM2 大容量メモリ、毎秒 933 GB のメモリ帯域幅、NVLink によるスケーラビリティをもたらします。 NVIDIA InfiniBand、NVIDIA Magnum IO、RAPIDS オーブンソースライブラリスイート (RAPIDS Accelerator for Apache Spark を含む) との組み合わせにより、NVIDIA データセンタープラットフォームは、かつてないレベルのパフォーマンスと効率で、巨大なワークロードに対応します。

― ディープラーニング トレーニング

NVIDIA A30 Tensor コア と Tensor Float (TF32) を利用することで、NVIDIA T4 と比較して最大 10倍のパフォーマンスをコード変更することなく得られます。さらに、Automatic Mixed Precision と FP16 の活用で 2倍の高速化が可能になり、スループットは合わせて 20倍に増えます。

NVIDIA NVLink、PCIe Gen4、NVIDIA Mellanox ネットワーキング、 NVIDIA Magnum IO SDK と組み合わせることで、数千の GPU までスケールできます。

Tensor コアと MIG により、A30 はいつでも柔軟にワークロードを処理できます。要求がピークのときには本稼働で推論に使用し、オフピーク時には一部の GPU を転用して同じモデルを高速で再トレーニングできます。

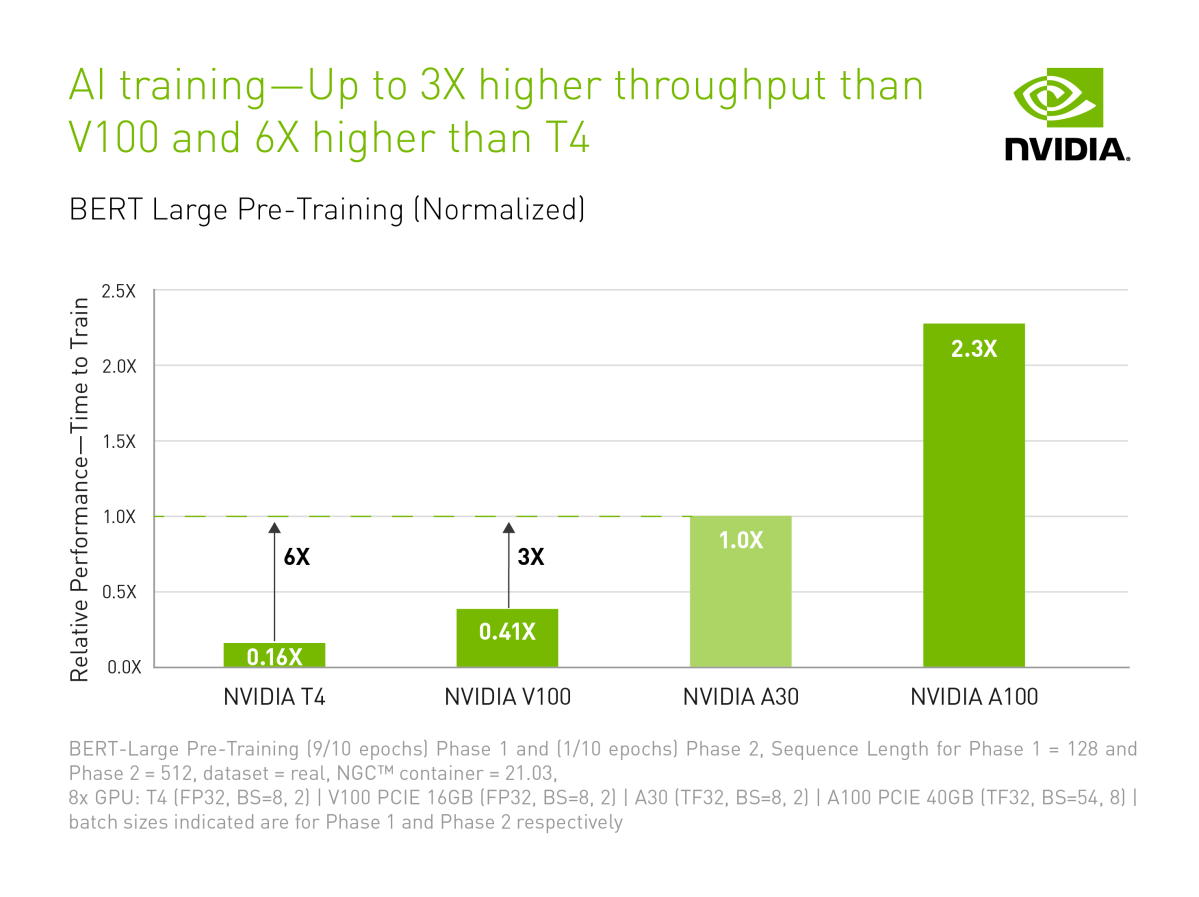

AI トレーニング — V100 の 3倍、T4 の 6倍のスループット

BERT Large ファインチューニング、収束までの時間

― ディープラーニング 推論

NVIDIA A30 には、推論ワークロードを最適化する画期的な機能が導入されています。FP64 から TF32 や INT4 まで、あらゆる精度を加速します。GPU あたり最大 4つの MIG をサポートする NVIDIA A30 では、安全なハードウェアパーティションで複数のネットワークを同時に運用でき、サービス品質 (QoS) が保証されます。また、スパース構造により数々の推論パフォーマンスの向上に加え、最大 2倍のパフォーマンスがもたらされます。

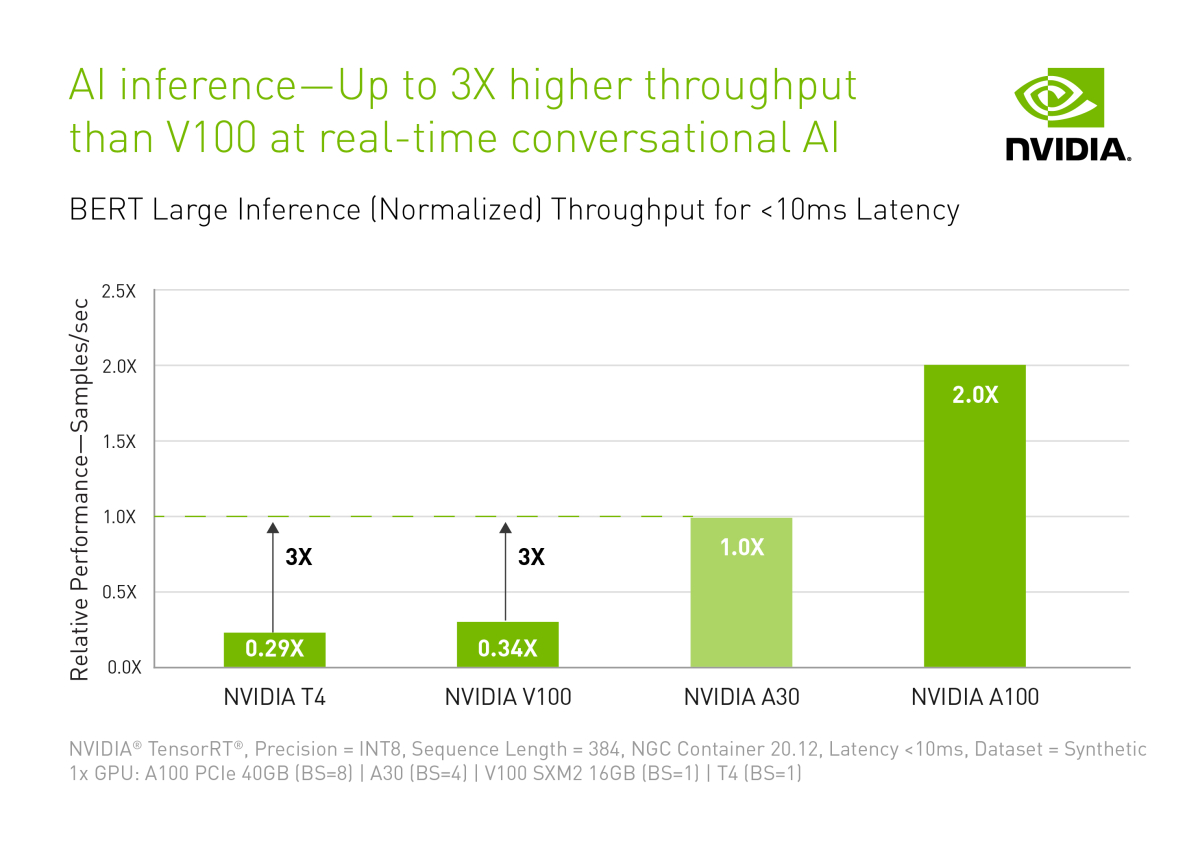

AI 推論 - リアルタイム対話型 AI で V100 と比較してスループットが最大 3倍

BERT Large 推論 (正規化済み)

レイテンシ 10ms 未満でのスループット

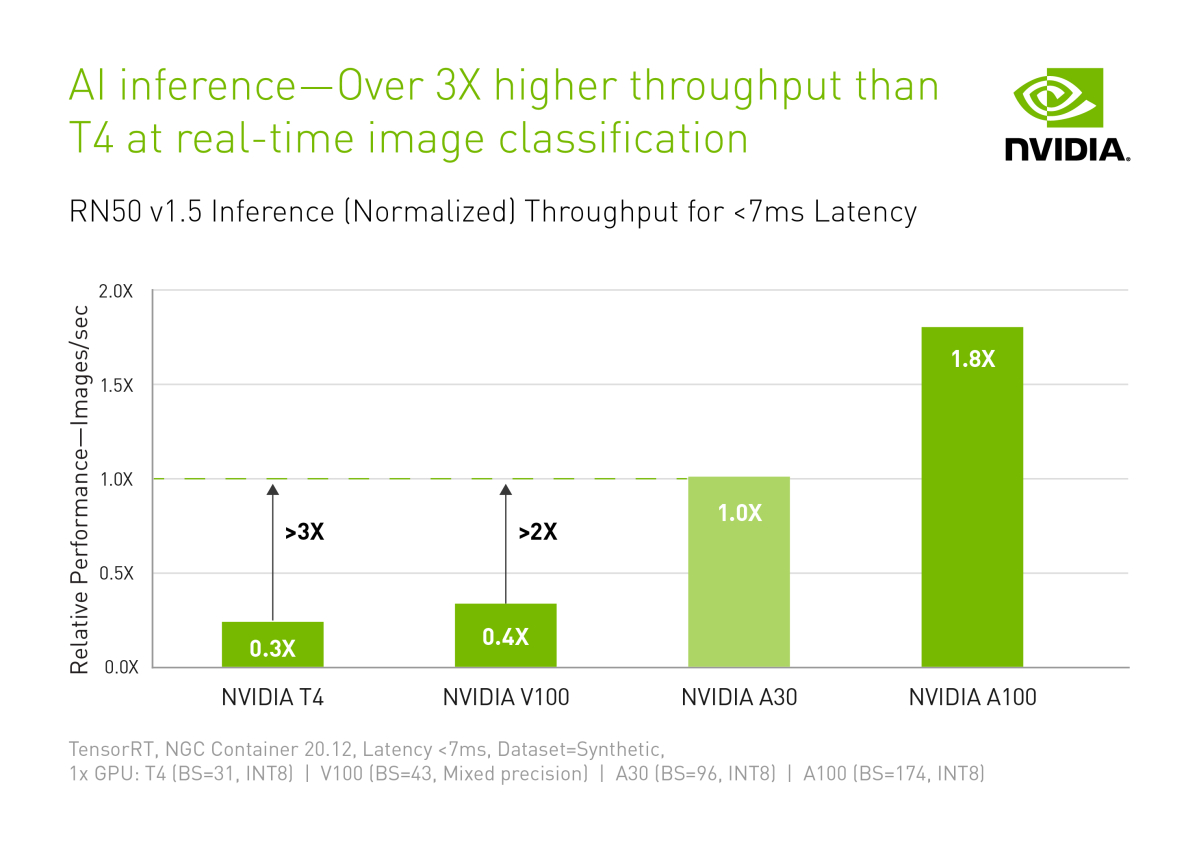

AI トレーニング— V100 の 3倍、T4 の 6倍のスループット

BRN50 v1.5推論 (正規化)

7ms 以下のレイテンシでのスループット

― ハイパフォーマンス コンピューティング

NVIDIA A30 は FP64 の NVIDIA Ampere アーキテクチャ Tensor コアを備えています。帯域幅が毎秒 933GB/s の GPU メモリ 24GB との組み合わせにより、倍精度計算を短時間で解決できます。HPC アプリケーションで TF32 を活用すれば、単精度の密行列積演算のスループットを上げることができます。

FP64 Tensor コアと MIG の組み合わせにより、研究機関は GPU を安全に分割して複数の研究者がコンピューティングリソースを利用できるようにし、QoS を保証し GPU 使用率を最大限まで高めることができます。AI を展開している企業は要求のピーク時に NVIDIA A30 を推論に利用し、オフピーク時には同じコンピューティングサーバを HPC や AI トレーニングのワークロードに転用できます。

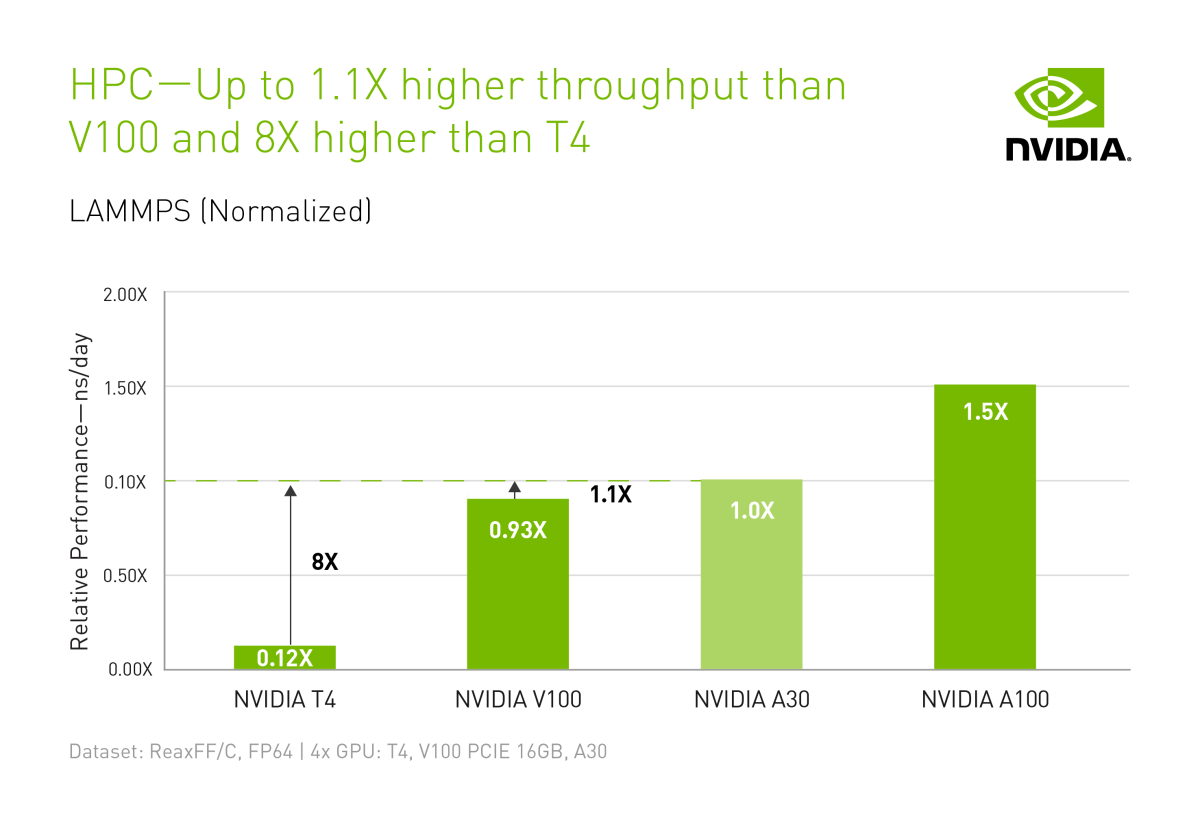

HPC — V100 と比較して最大 1.1 倍、T4 と比較して 8 倍のスループット

LAMMPS (正規化済み)

― NVIDIA A30 datasheet

製品仕様

A30 / A100 仕様比較

| A30 | A100-PCIe | |

| FP64 | 5.2 teraFLOPS | 9.7 teraFLOPS |

| FP64 Tensor コア | 10.3 teraFLOPS | 19.5 teraFLOPS |

| FP32 |

10.3 teraFLOPS |

19.5 TFLOPS |

| TF32 Tensor コア | 82 teraFLOPS | 165 teraFLOPS* |

156 teraFLOPS | 312 teraFLOPS* |

| BFLOAT16 Tensor コア | 165 teraFLOPS | 330 teraFLOPS* |

312 teraFLOPS | 624 teraFLOPS* |

| FP16 Tensor コア | 165 teraFLOPS | 330 teraFLOPS* |

312 teraFLOPS | 624 teraFLOPS* |

| INT8 Tensor コア | 330 TOPS | 661 TOPS* |

624 TOPS | 1,248TOPS* |

| INT4 Tensor コア | 661 TOPS | 1321 TOPS* |

1,248 TOPS | 2,496 TOPS* |

| メディア エンジン | 1 optical flow accelerator (OFA) 1 JPEG デコーダー (NVJPEG) 4 ビデオ デコーダー (NVDEC) |

1 optical flow accelerator (OFA) 5 JPEG デコーダー (NVJPEG) 5 ビデオ デコーダー (NVDEC) |

| GPU メモリ | 24GB HBM2 | 40GB HBM2 |

| GPU メモリ帯域幅 | 933GB/s | 1,555GB/s |

| 相互接続 | PCIe Gen4: 64GB/s NVIDIA NVLINK: 200 GB/s** |

PCIe Gen4: 64GB/s NVIDIA NVLink 600 GB/s** |

| フォーム ファクター | Dual-slot, full-height, full-length (FHFL) |

Dual-slot, full-height, full-length (FHFL) |

| 最大熱設計電力 (TDP) |

165W | 250W |

| マルチインスタンス GPU (MIG) |

6GBのGPUインスタンスが4つ 12GBのGPUインスタンスが2つ 24GBのGPUインスタンスが1つ |

5GBのGPUインスタンスが7つ 10GBのGPUインスタンスが4つ 20GBのGPUインスタンスが2つ 40GBのGPUインスタンスが1つ |

* With sparsity

** NVLink Bridge for up to two GPUs

製品案内

- NVIDIA Tensor Core GPU

- NVIDIA H100 NEW

- A800 40GB Active NEW

- NVIDIA A10

- NVIDIA A30

- NVIDIA A100

- NVIDIA V100s

- NVIDIA T4

- NVIDIA V100

- NVIDIA Quadro SERIES

- RTX 4500 Ada NEW

- RTX 4000 Ada NEW

- L40S NEW

- RTX 5000 Ada NEW

- RTX 4000 SFF Ada NEW

- RTX 6000 Ada NEW

- NVIDIA L40

- NVIDIA RTX A5500

- NVIDIA RTX A4500

- NVIDIA A40

- NVIDIA RTX A6000

- NVIDIA RTX A5000

- NVIDIA RTX A4000

- Quadro RTX8000 Passive

- Quadro RTX8000

- Quadro RTX6000

- Quadro GV100

- Quadro GP100

- Quadro P6000

- NVIDIA TITAN SERIES

- NVIDIA TITAN RTX

- NVIDIA TITAN V

- NVIDIA TITAN Xp

- NVIDIA TITAN Xp-SW

- NVIDIA GeForce SERIES

- GeForce RTX3090

- GeForce RTX2080Ti

- GeForce GTX1080Ti

- GeForce GTX1080

- GPUワークステーション

- HPCT WRSE31-4GP

- HPCT WR17as-4GP

- HPCT WR13as-4GP

- HPCT W117gs

- HPCT W116gs

- HPCT W216gs

- HPCT WR16gs

- HPCT WRSX42-4GP NEW

- HPCT WRSX31-4GP

- HPCT WRSX32-4GP

- HPCT WR26gs-Silent

- HPCT WR26gs

- GPUラックマウントサーバ

- HPCT RS2E41-4GP NEW

- HPCT RG2E42-4GPNEW

- HPCT RG2E31-4GP

- HPCT R217gg-4GP

- HPCT RG2E32-8GP

- HPCT R227gg-8GP

- HPCT RS4E42-8GP NEW

- HPCT RS4E32-8GP

- HPCT R427as-8GP

- HPCT R116gs

- HPCT RS1X32-4GP

- HPCT R126gs

- HPCT R126gs-4GP

- HPCT RS2X41-2GP NEW

- HPCT RS2X42-4GP NEW

- HPCT RS2X32-6GP

- HPCT R226gs

- HPCT R426gs-8GP

- HPCT RS4X42-8GP NEW

- HPCT RS4X32-10GP

- HPCT R426gs-10GP

- GPUラックマウントサーバ

- for NVLink - NVIDIA DGX H100 NEW

- NVIDIA DGX A100

- HPCT RS2E32-4GN

- HPCT R227as-4GN

- HPCT RS4X42-4GN NEW

- HPCT RS2X32-4GN

- HPCT R126gs-4GN

- HPCT RS4E32-8GN

- HPCT R427as-8GN

- HPCT RS4X32-8GN

- HPCT R426gs-8GN

- HPCT RX26gs-16GN

- 販売終息製品

- サービス

- セットアップサービス

- DL クラスタ管理

- ベンチマーク情報

- NVIDIA GPU CLOUD

- GPUアプリケーション

- 化学・量子化学

- AMBER

- GROMACS

- NAMD

- 量子化学

- GAMESS-UK

- GAMESS-US

- 物質科学

- VASP

- 数値解析

- MATLABS

- Mathematica

- 数値流体力学

- Ansys Fluent

- 構造力学

- Abaqus

- Ansys Mechanical

- LS-DYNA

- MSC Nastran

- MSC Marc

- 電磁界

- CST Microwave

Studio(MWS) - JMAG

- タンパク質構造解析

- AlphaFold

- RELION

- GPUユーザレポート

- GPU TEST DRIVE CENTER

- GPUテストドライブとは

- HPCT-Trial

- 導入事例

- 会社情報

- サポート

- お取引・お問い合わせ