GPU Solution:PCIe

NVIDIA DGX STATION A100

AI 時代のワークグループアプライアンス NVIDIA DGX STation A100

NVIDIA DGX Station™ A100 は、AI スーパーコンピューティングをデータサイエンスチームにもたらし、データセンターや IT インフラストラクチャの増設なしにデータセンターテクノロジを提供します。NVIDIA DGX Station A100 は複数ユーザが同時に接続できるように設計されており、オフィスに適したフォームファクタでサーバグレードコンポーネントを活用します。完全に相互接続されたマルチインスタンス GPU(MIG)対応の 4基の NVIDIA A100 Tensor コア GPU と全体で最大 320GB の GPUメモリを備えた唯一のシステムであり、標準的な電源コンセントを利用できるため、どこにでも配置できる強力な AI アプライアンスです。

NVIDIA DGX Station A100 概要

・チームが無制限に使用できる 2.5petaFLOPS の性能を提供可能な AI ワークグループサーバ。

・トレーニング、推論、およびデータ分析用。

・サーバグレードのプラグアンドゴー方式。データセンターの電力と冷却が不要。

・世界最高峰の AI プラットフォーム。複雑なインストールや IT のサポートが不要。

・完全に相互接続された 4基の NVIDIA A100 Tensorコア GPU と、最大 320GB の GPU メモリを搭載

した世界で唯一のワークステーション型システム。

・NVIDIA のノウハウと経験を活かして AI トランスフォーメーションを速やかに実現。

データサイエンスチーム向けのAIスーパーコンピューティング

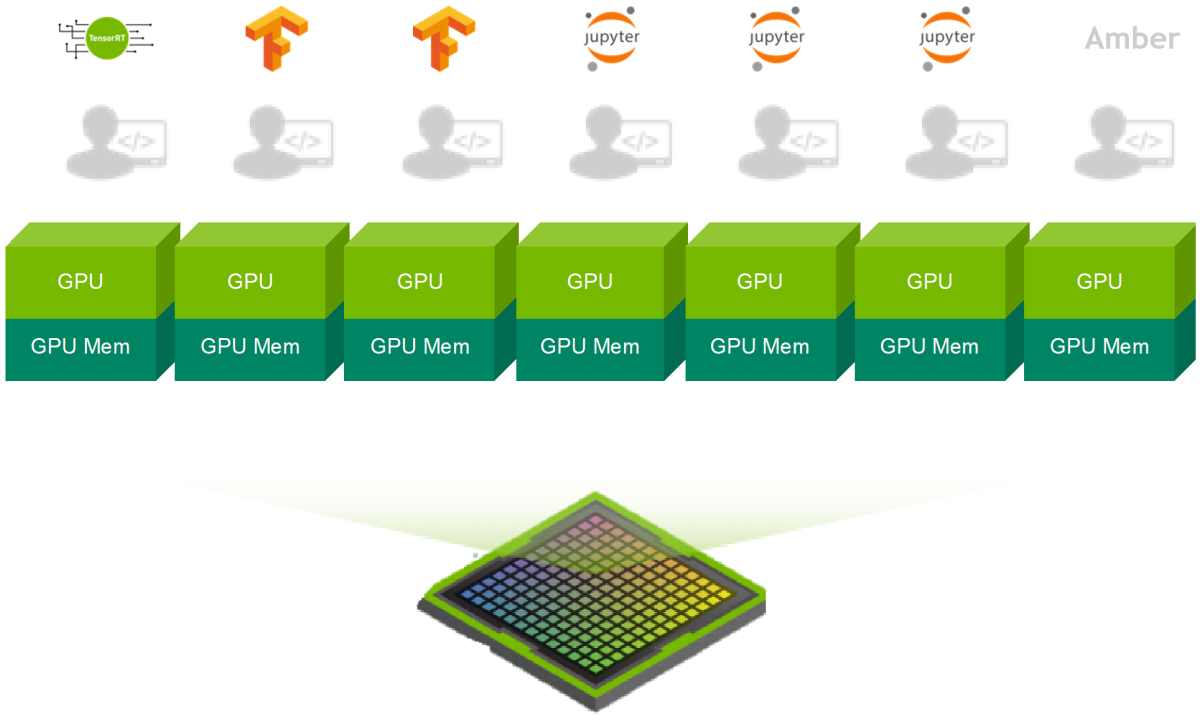

NVIDIA DGX Station A100 は、複数の同時接続ユーザーに集中型 AI リソースを手軽に提供できる AI 時代のワークグループアプライアンスです。 MIG を使うことで最大 28台の独立した GPU デバイスとして個々のユーザとジョブに割り当てる事が可能で、トレーニング、推論、分析のワークロードを行う際にシステム全体の性能に影響を与えません。

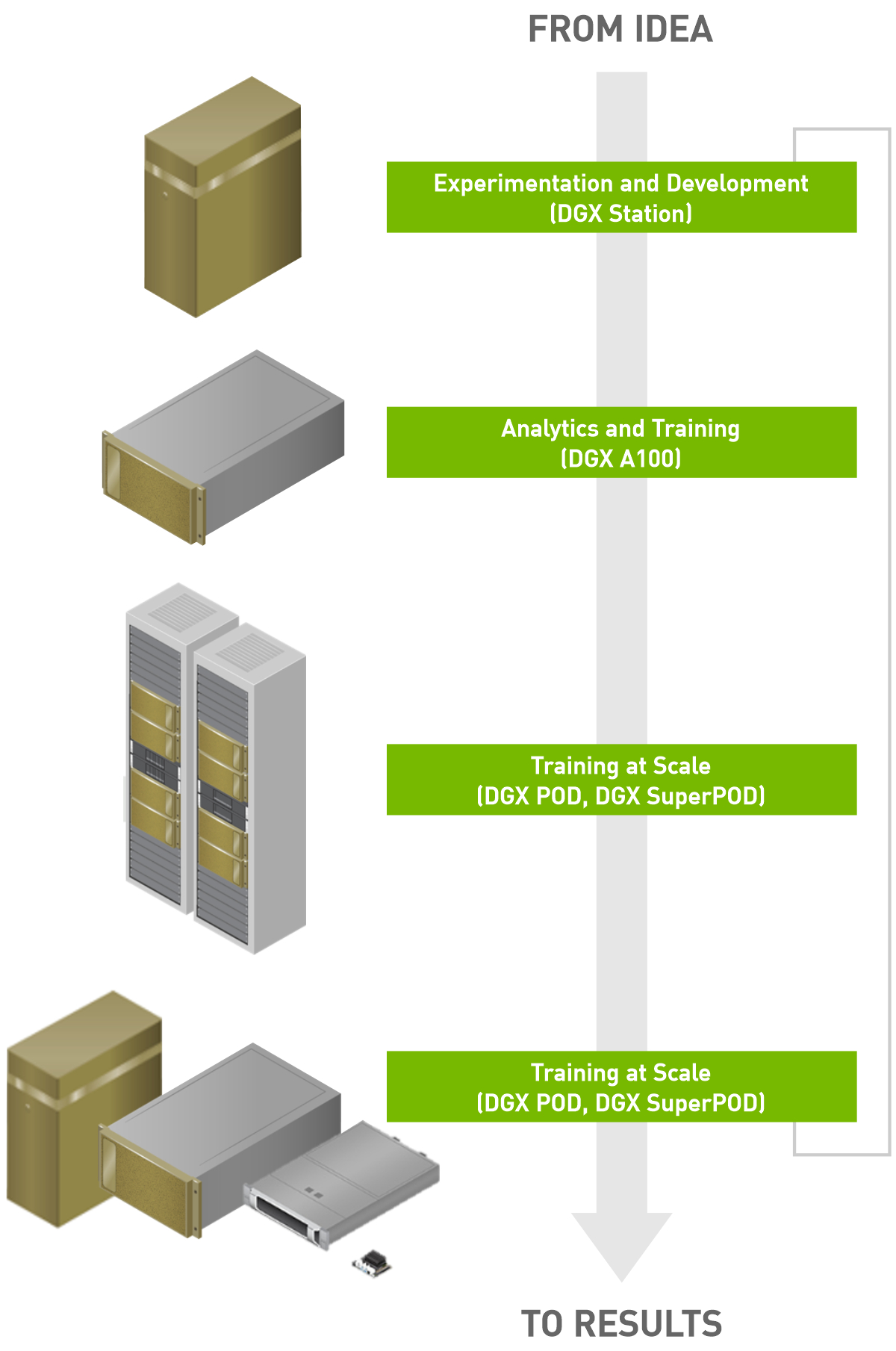

NVIDIA DGX Station A100 はすべての DGX システムと同じく完全に最適化された NVIDIA DGX™ ソフトウェアスタックを備えています。個々のシステムからNVIDIA DGX POD™ や NVIDIA DGX SuperPOD™ に至るまで、最高の性能と DGX ベースインフラストラクチャとの完全相互運用性を提供しており、規模の大小を問わずあらゆる組織のチームにとって理想的なプラットフォームとなります。

データセンターなしでデータセンターの性能を実現

NVIDIA DGX Station A100 は、ワークステーションのフォームファクタでデータセンター級の AI サーバを実現し、専用の電源と冷却なしに標準的なオフィス環境で使用するのに適しています。4つの超強力な NVIDIA A100 Tensorコア GPU、最上位のサーバグレード CPU、超高速 NVMe ストレージ、および最先端の PCIe Gen4 バスを備える設計になっています。DGX Station A100 にも NVIDIA DGX A100 と同じベースボードマネジメントコントローラ(BMC)が搭載されており、システム管理者はリモート接続によって要求タスクを実行できます。DGX Station A100 は、オフィス環境向けの最も強力な AI システムであり、データセンターなしにデータセンターテクノロジを提供します。

どこにでも配置できる AI アプライアンス

NVIDIA DGX Station A100 は、企業のオフィス、実験室、研究施設、さらには自宅から作業する昨今のアジャイルデータサイエンスチーム向けに設計されています。大規模な AI インフラストラクチャを設置するには多大なIT投資と工業用の強力な電源供給と冷却機能を備えた大型データセンターが必要ですが、DGX Station A100 なら、お客様のチームの作業スペースがどこにあっても標準的な壁のコンセントに接続するだけです。DGX Station A100 は1人で簡単にセットアップができて、世界最高峰の AI プラットフォームを数分で立ち上げて稼働させることができます。

モデルの大規模化、応答の高速化

NVIDIA DGX Station A100 はワークステーションではありません。これは、デスクの下に設置できる AI ワークグループサーバです。64 コアのデータセンターグレード CPU に加えて、NVIDIA DGX A100 サーバと同じ NVIDIA A100 Tensorコア GPUを備え、それぞれ 40GB または 80GB の GPUメモリが高速な SXM4 を介して接続されています。NVIDIA DGX Station A100 は、NVIDIA® NVLink® を活用して 4つの GPU を完全相互接続し、かつ MIG 対応でシステム性能に影響を与えずに並列ジョブと複数のユーザー向けに最大 28台の独立した GPUデバイスを提供する唯一のオフィスに適したシステムです。

Up To 7 GPU Instances In a Single A100

比類なき AI ノウハウへの統合アクセス

NVIDIA DGX Station A100 は、NVIDIA の数千人の AI 専門家に支えられた完全なハードウェア&ソフトウェアプラットフォームであり、世界最大の DGX 実験場である NVIDIA DGX SATURNV から得られた知識に基づいて構築されています。DGX Station A100 を所有すれば、NVIDIA DGXperts に直接アクセスできます。NVIDIA DGXperts は、AI に精通した専門家の国際チームであり、NVIDIA の 10年を超える AI リーダーシップのノウハウと経験に基づき、AI 変革の急速な発展に貢献する規範的なガイダンスと設計の専門知識を提供します。これにより、ミッションクリティカルなアプリケーションが確実に素早く立ち上がってスムーズに稼働し続けることになり、インサイトを得るまでの時間が大幅に改善されます。

パフォーマンス

システム仕様

| DGX Station A100 320GB |

DGX Station A100 160GB |

|

| GPUs | 4x NVIDIA A100 80 GB GPUs |

4x NVIDIA A100 40 GB GPUs |

| GPU Memory | 320 GB total | 160 GB total |

| Performance | 2.5 petaFLOPS AI, 5 petaOPS INT8 | |

| System Power Usage | 1.5 kW at 100-120 Vac | |

| CPU | Single AMD 7742, 64 cores, 2.25 GHz (base)-3.4 GHz (max boost) |

|

| System Memory | 512 GB DDR4 | |

| Networking | Dual-port 10Gbase-T Ethernet LAN Single-port 1Gbase-T Ethernet BMC management port |

|

| Storage | OS: 1x 1.92 TB NVME drive Internal storage: 7.68 TB U.2 NVME drive |

|

| DGX Display Adapter | 4 GB GPU memory, 4x Mini DisplayPort | |

| System Acoustics | < 37 dB | |

| Software | Ubuntu Linux OS | |

| System Weight | 91.0 lbs (43.1 kgs) | |

| Packaged System Weight | 127.7 lbs (57.93 kgs) | |

| System Dimensions | Height: 25.1 in (639 mm) Width: 10.1 in (256 mm) Length: 20.4 in (518 mm) |

|

| Operating Temperature Range | 5-35 oC (41-95 oF) | |

前世代との仕様比較

| DGX Station V100 | DGX Station A100 320GB |

DGX Station A100 160GB |

|

| GPU |

4x NVIDIA Tesla V100 PCIe GPU |

4x NVIDIA A100 Tensor GPU | |

| GPU Memory (Total) |

128GB HBM | 320GB HBM2e | 160GB HBM2 |

| CPU | Intel Xeon E5-2698 v4 2.2 GHz, 20 Cores PCIe Gen3 |

AMD Epyc 7742 2.25 GHz - 3.4 GHz, 64 Cores PCIe Gen4 |

|

| System Memory | 256GB RDIMM DDR4 @2667MT/s | 512GB DDR4 @3200MT/s | |

| Boot drive | 1X 1.92 TB SATA III SSD | 1 x 1.92 TB M.2 PCIe Gen3 | |

| Cache storage | 3X 1.92 TB SATA III SSD RAID 0 | 1 x 7.68 TB U.2 PCIe Gen4 | |

| Networking | 2 x 10GbE (RJ-45) | 2 x 10GbE (RJ-45) | |

| Display GPU | 3X DisplayPort, 4K resolution | 4GB HBM 4 x mini DisplayPort |

|

| Remote Management |

N/A | On board BMC, 1GbE (RJ-45) MGMT port, AST2500 based, IPMI, Redfish |

|

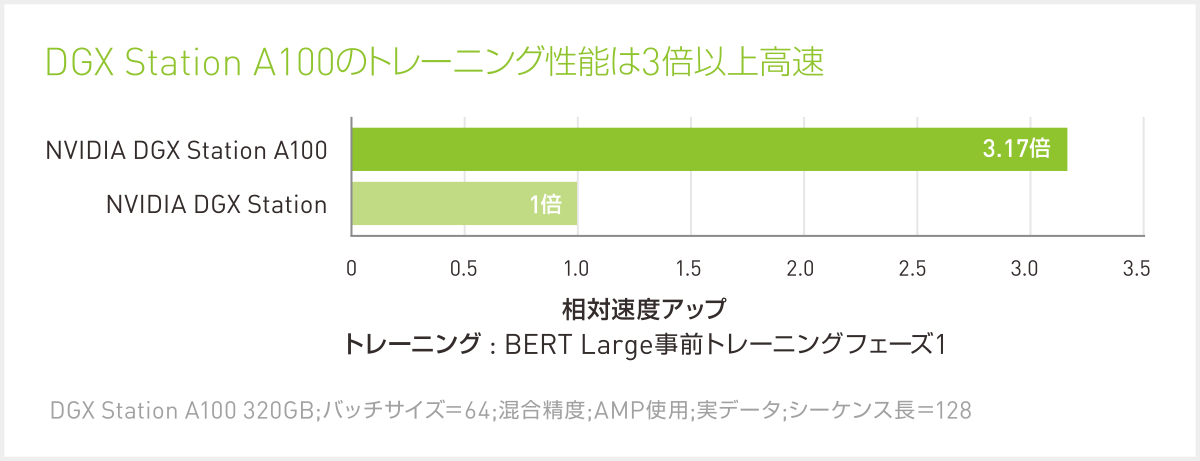

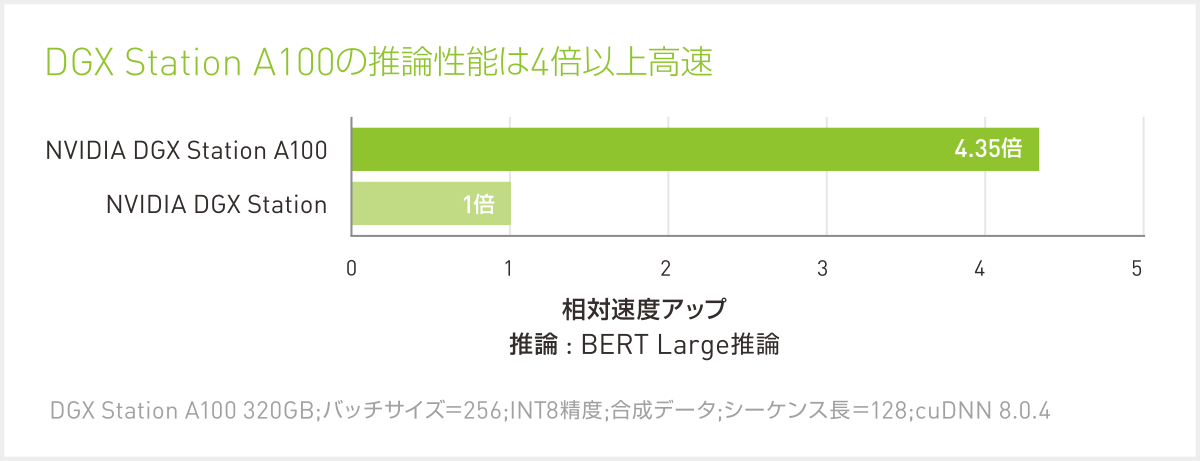

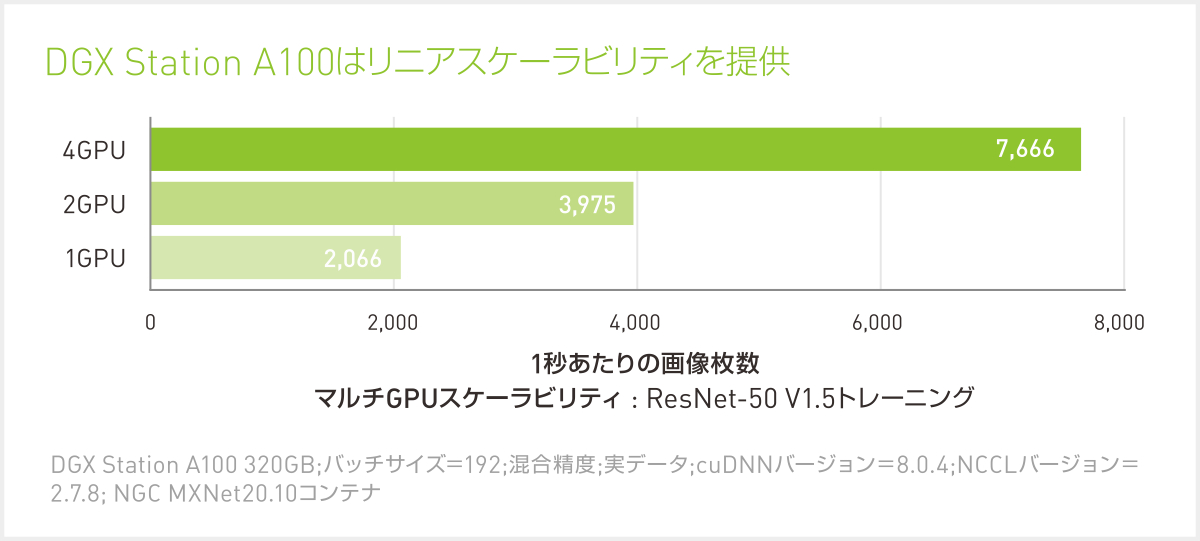

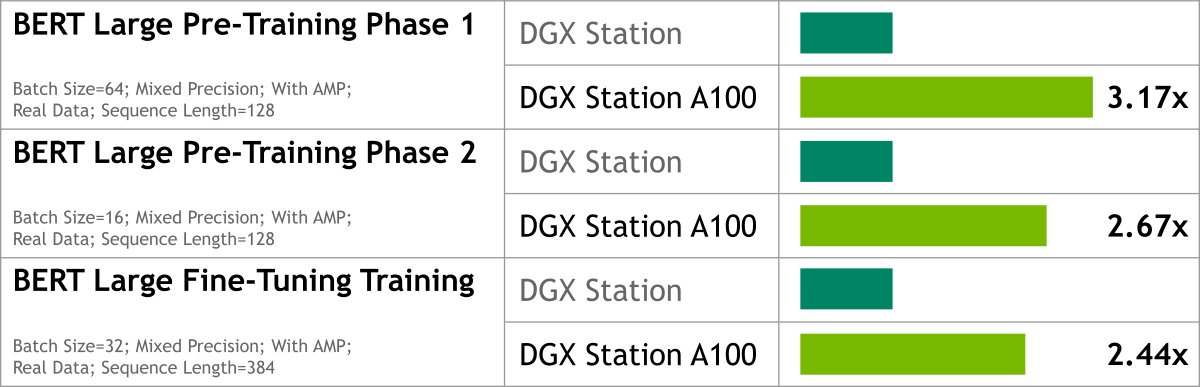

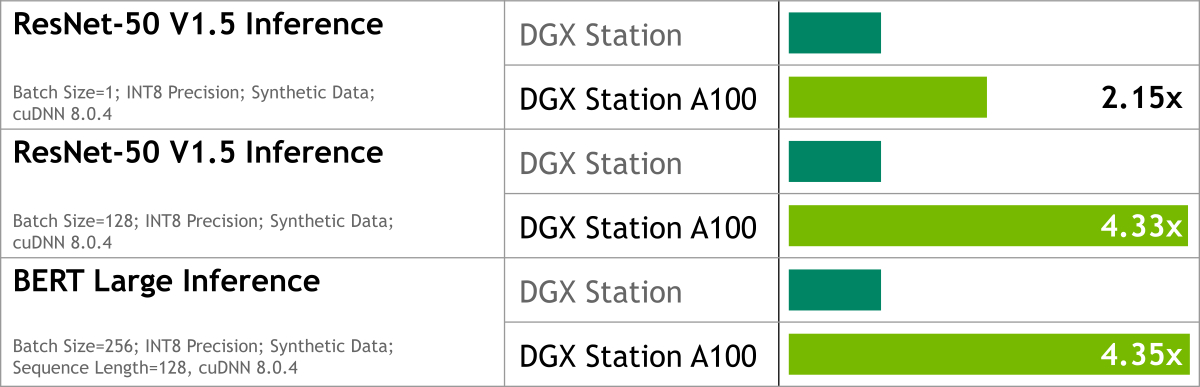

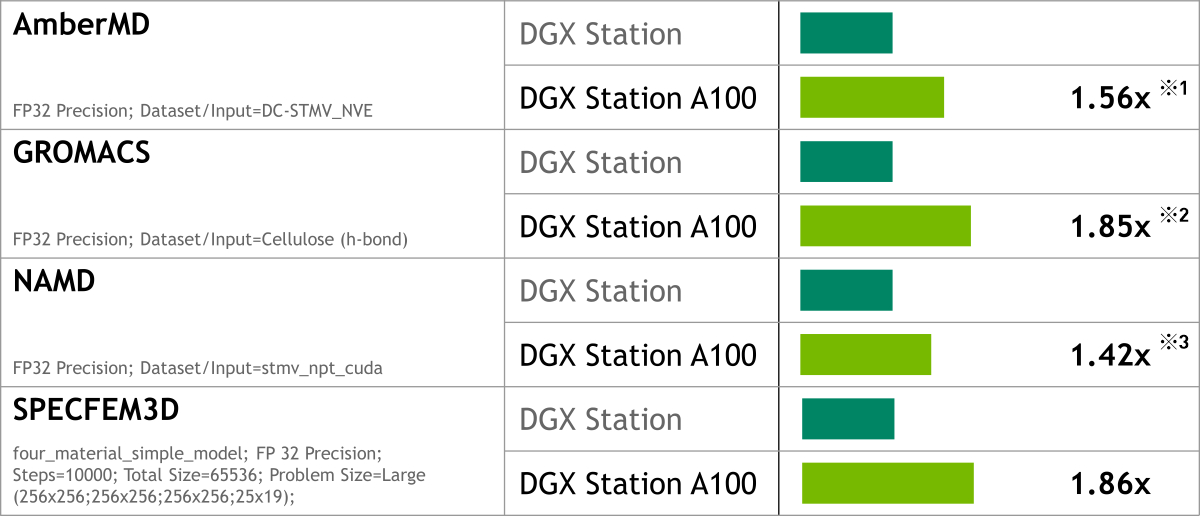

前世代とのパフォーマンス比較

Over 3X Increase in AI Training Performance

Over 4X Increase in AI Inference Performance

Almost 2X Increase in Scientific HPC Workload Performance

※1 = best value. Average is 1.3x across all these inputs: DC-Cellulose_NPT; DC-Cellulose_NVE; DC-FactorIX_NPT; DC-FactorIX_NVE; DC-GTI_Complex; DC-JAC_NPT; DC; JAC_NVE; DC-Myoglobin; DC-Nucleosome; DC-STMV_NPT; DC-STMV_NVE

※2 = best value. Average is 1.5x across all these inputs: ADH Dodec (h-bond); Cellulose (h-bond); STMV (h-bond)

※3 = best value. Average is 1.3x across all these inputs: apoa1_npt_cuda; apoa1_nptsr_cuda; apoa1_nve_cuda; stmv_npt_cuda; stmv_nptsr_cuda; stmv_nve_cuda

NVIDIA DGX Station A100 カタログ

製品案内

- NVIDIA Tensor Core GPU

- NVIDIA H100 NEW

- A800 40GB Active NEW

- NVIDIA A10

- NVIDIA A30

- NVIDIA A100

- NVIDIA V100s

- NVIDIA T4

- NVIDIA V100

- NVIDIA Quadro SERIES

- RTX 4500 Ada NEW

- RTX 4000 Ada NEW

- L40S NEW

- RTX 5000 Ada NEW

- RTX 4000 SFF Ada NEW

- RTX 6000 Ada NEW

- NVIDIA L40

- NVIDIA RTX A5500

- NVIDIA RTX A4500

- NVIDIA A40

- NVIDIA RTX A6000

- NVIDIA RTX A5000

- NVIDIA RTX A4000

- Quadro RTX8000 Passive

- Quadro RTX8000

- Quadro RTX6000

- Quadro GV100

- Quadro GP100

- Quadro P6000

- NVIDIA TITAN SERIES

- NVIDIA TITAN RTX

- NVIDIA TITAN V

- NVIDIA TITAN Xp

- NVIDIA TITAN Xp-SW

- NVIDIA GeForce SERIES

- GeForce RTX3090

- GeForce RTX2080Ti

- GeForce GTX1080Ti

- GeForce GTX1080

- GPUワークステーション

- HPCT WRSE31-4GP

- HPCT WR17as-4GP

- HPCT WR13as-4GP

- HPCT W117gs

- HPCT W116gs

- HPCT W216gs

- HPCT WR16gs

- HPCT WRSX42-4GP NEW

- HPCT WRSX31-4GP

- HPCT WRSX32-4GP

- HPCT WR26gs-Silent

- HPCT WR26gs

- GPUラックマウントサーバ

- HPCT RS2E41-4GP NEW

- HPCT RG2E42-4GPNEW

- HPCT RG2E31-4GP

- HPCT R217gg-4GP

- HPCT RG2E32-8GP

- HPCT R227gg-8GP

- HPCT RS4E42-8GP NEW

- HPCT RS4E32-8GP

- HPCT R427as-8GP

- HPCT R116gs

- HPCT RS1X32-4GP

- HPCT R126gs

- HPCT R126gs-4GP

- HPCT RS2X41-2GP NEW

- HPCT RS2X42-4GP NEW

- HPCT RS2X32-6GP

- HPCT R226gs

- HPCT R426gs-8GP

- HPCT RS4X42-8GP NEW

- HPCT RS4X32-10GP

- HPCT R426gs-10GP

- GPUラックマウントサーバ

- for NVLink - NVIDIA DGX H100 NEW

- NVIDIA DGX A100

- HPCT RS2E32-4GN

- HPCT R227as-4GN

- HPCT RS4X42-4GN NEW

- HPCT RS2X32-4GN

- HPCT R126gs-4GN

- HPCT RS4E32-8GN

- HPCT R427as-8GN

- HPCT RS4X32-8GN

- HPCT R426gs-8GN

- HPCT RX26gs-16GN

- 販売終息製品

- サービス

- セットアップサービス

- DL クラスタ管理

- ベンチマーク情報

- NVIDIA GPU CLOUD

- GPUアプリケーション

- 化学・量子化学

- AMBER

- GROMACS

- NAMD

- 量子化学

- GAMESS-UK

- GAMESS-US

- 物質科学

- VASP

- 数値解析

- MATLABS

- Mathematica

- 数値流体力学

- Ansys Fluent

- 構造力学

- Abaqus

- Ansys Mechanical

- LS-DYNA

- MSC Nastran

- MSC Marc

- 電磁界

- CST Microwave

Studio(MWS) - JMAG

- タンパク質構造解析

- AlphaFold

- RELION

- GPUユーザレポート

- GPU TEST DRIVE CENTER

- GPUテストドライブとは

- HPCT-Trial

- 導入事例

- 会社情報

- サポート

- お取引・お問い合わせ